在AI技术的狂飙突进中,2024年给整个行业带来了较大的变革与震撼。多模态AI模型的横空出世,让智能设备拥有了看、听、说的能力;从云端奔涌向端侧和边缘侧的算力需求转移,如同一场“大迁徙”,带来一场新的博弈;算力价格产生“松动”,AI技术的普及门槛大幅降低,带动了更多中小企业和开发者跃跃欲试……

在这样的时代狂潮中,AI芯片如何在市场巨浪中找准定位,已然成了一个迫切需要解答的问题。

小模型、多模态、预训练……AI何去何从?

2024年,AI领域出现了一些新的技术趋势,包括小数据、大规模预训练模型、大模型微调、多模态大模型等等。这些趋势的走向如何?业界又将如何布局未来的市场?

Arm中国区业务全球副总裁邹挺,重点谈到了多模态AI模型和小语言模型。他认为,多模态AI模型正迅速演进,超越传统大语言模型(LLM)的文本处理能力,整合图像、音频和传感器数据,赋予AI类似人类的感知能力,使其能更全面地理解世界并进行互动。

与此同时,Arm预计小语言模型(SLM)将在2025年迎来加速发展。这类模型具有更高的压缩率和量化能力,参数更少、资源需求更低,易于定制和部署,尤其适合在计算资源受限的设备上运行。预计到2025年,这类模型的数量将显著增加,且在任务中的使用也将越来越广泛,包括语言和设备交互,以及基于视觉的任务,例如事件解读和扫描等。这些模型能够直接在边缘设备上运行,提升性能的同时也增强隐私保护。

中存算董事长陈巍表示,目前看大模型逐渐从文本的单一模态走向多模态、混合模态,包含视频等多元传感信息的世界模型是大模型发展的“圣杯”,会是未来的焦点。但世界模型对算力芯片的要求也极高,需要通过更多新架构和集成技术去实现。他们正在按照世界模型的目标来优化架构,包括整合先进CAG(Cache-Augmented Generation)等前瞻技术。

模型和算力的“双向奔赴”是安谋科技产品总监鲍敏祺强调的变化。得益于模型数据质量的显著提升,原本需要百亿参数级别的模型规模现在可以降低至十几亿参数级别。换言之,随着数据质量的不断提高,小模型的性能也会随之得到优化,这样就能够让整个端侧的AI算法应用变得更加灵活。

此外,多模态模型因涉及语音、图像、视频等数据源,其上下文长度增加,导致算力需求上升,需提前布局应对。同时,模型训练和微调的应用范围更为广阔,如OpenAI的最新模型在一次推理中多次调用以优化结果,与之对应的是增加了算力需求。未来三年,基于Transformer结构进行推理仍将是主流,端侧大模型需在支持更长上下文和低延时之间找到平衡,以应对多样化的推理任务。

算力迁徙,端、边如何发展?

生成式AI趋势下,云边端一体化的混合AI架构,正在推动AI技术在更多领域的广泛应用。

后摩智能联合创始人、产品副总裁信晓旭认为,云端AI将继续在AI技术演进上发挥核心作用,特别是在模型训练和大规模数据处理方面。

同时,他看好端侧和边缘侧AI的巨大成长潜力,因为它们更接近数据源,更贴近场景,能够针对性地提供个性化服务、实时响应和更好的数据隐私保护,尤其是多模态大模型的爆发将会加速这一进程。随着生成式AI技术的发展,端边侧设备将能够执行更复杂的任务,如内容生成、决策支持和交互式学习,推动端侧设备从数据收集点转变为本地智能决策终端。目前,后摩智能专注于开发能够支持端、边侧大模型部署的AI芯片及配套硬件产品,通过存算一体架构实现算力和功耗方面的优势。他透露,2025年,后摩智能计划推出新款芯片,进一步提升性能,加速端边设备部署大模型的进程。

Imagination公司产品管理副总裁Dennis Laudick谈到,AI应用在边缘和端侧设备中的需求主要集中在网络受限、实时响应和安全性要求高的场景。生成式AI在这些场景中展现出巨大潜力,尤其是在Transformer架构下,其生成内容的高效性和逼真性受到市场青睐。多模态生成式AI和个性化体验正不断涌现,其应用范围也在持续拓展至自动驾驶、图像处理等领域。Imagination希望通过提供可编程GPU和并行计算平台,助力生成式AI的消费者体验革命。

邹挺认为,2024年,AI大模型从云端向边缘和终端下沉的趋势日益显著,2025年,或将出现复杂的混合AI架构,这些架构将AI任务分配到边缘设备和云端之间。系统将在边缘设备上运行AI算法以检测感兴趣的事件,而云端模型则负责提供附加信息。最终,决定是在本地还是云端运行AI工作负载,将取决于可用电力、延迟要求、隐私考虑和计算复杂性等因素。

针对边缘和端侧市场的巨大潜力,Arm当前主要聚焦于解决AI推理从云端扩展到边缘及端侧所面临的复杂性问题,例如针对智能终端市场推出Arm终端计算子系统(CSS)、面向汽车市场将服务器级的Neoverse CPU引入Arm汽车增强(AE)IP产品线、在物联网领域通过从Cortex-M到Cortex-A的广泛产品满足多样需求。

陈巍则认为,具身智能和大模型的家用落地会进一步推动边缘生成式AI的发展,目前正与合作方共同推进云/边缘计算的编译生态和MaaS生态,在大模型办公一体机和大模型盒子方面进行高性价比产品的布局。

谈及国内AI产业在云、边、端发展环境与海外市场的差异,鲍敏祺表示,国内AI产业的独特优势在于国内超大市场的规模化优势,如完备的电力、通信等基础设施、海量用户群体和丰富的数据积累,以及成熟的产业分工,为本土AI产业发展提供了坚实基础。安谋科技自研“周易”NPU通过IP设计增加可扩展性,不仅可以满足端侧AI的算力需求,还能配合其他通用算力单元实现混合AI的多样化算力拓展。

算力降阶,AI芯片面临冲击?

2024年,AI市场的供需变化也是一个显著趋势,出现了AI算力价格的下调。这给AI芯片的落地应用带来哪些挑战?又将如何影响AI芯片下一步的发展?

陈巍首先认为,从摩尔定律的角度看,AI算力的价格下调非常正常。算力成本的下降对大模型的广泛落地和应用,具有非常关键的意义。事实上,更多的大模型落地,会进一步带动AI芯片的销售和发展。按照目前的趋势,大模型和大模型计算芯片正从研究成果快速转化为生产力,AI芯片的研发目标也在变化,成本要更低。

“2024年是AI算力基础设施市场的一次重构。我在2023年初对ChatGPT进行分析时,就预测推理需求会超过训练成为主要的大模型算力需求,高性价比的算力会成为大模型厂商竞争的关键。对国内AI芯片厂商来说,如何在半导体竞争的大背景下降低芯片成本,既是机会也是挑战”,他表示。

鲍敏祺谈到,AI算力价格下调的本质是供需关系错配的结果。当前,AI应用的类型和数量有限,市场对算力的需求并不大,而算力供应相对充足,导致市场呈现买方态势,从而促使算力价格呈现“内卷”态势。然而,随着多模态和世界模型的加速成熟,以及端侧应用场景的不断涌现,对于AI算力需求将攀升,供需关系可能在未来达到平衡,进而影响算力定价策略。

在他看来,AI芯片面临的挑战不仅来自云端的制程工艺和算力供应受限,端侧也面临算法迅速增长、软件生态割裂的现状,如何实现算法快速部署成为难题。同时,当前终端市场和产业环境瞬息万变,芯片厂商需要在有限的时间窗口内完成产品定义、设计、制造和上市等流程,以抢占市场竞争先机。综合来看,在“内卷”的产业环境下,追求高效的Go-to-Market或许比一味追求自研创新更加重要,也更加符合当下的市场竞争需求。从这个角度来说,也为IP厂商等上游技术供应方提供了更多机遇。

信晓旭则认为,算力价格下调将使AI技术更易获取,降低了企业尤其是中小企业的使用成本,从而推动AI应用的普及和落地,也为AI芯片带来扩大市场和深化合作的机遇。然而,随着算力价格的下降,市场对AI芯片的算力和能效比要求更高,AI芯片厂商需要在保持竞争力的同时,提供更高效、更经济的解决方案,在技术创新和成本控制上做出更大的努力。

对于AI芯片的下一步研发,这意味着需要更加注重性能优化和能效比的提升。“在算力价格下调的市场环境下,存算一体AI芯片能够提供更高的性价比,满足市场对于成本效益和能效比的双重需求”,他补充。

国产AI芯片将经历泡沫破裂?

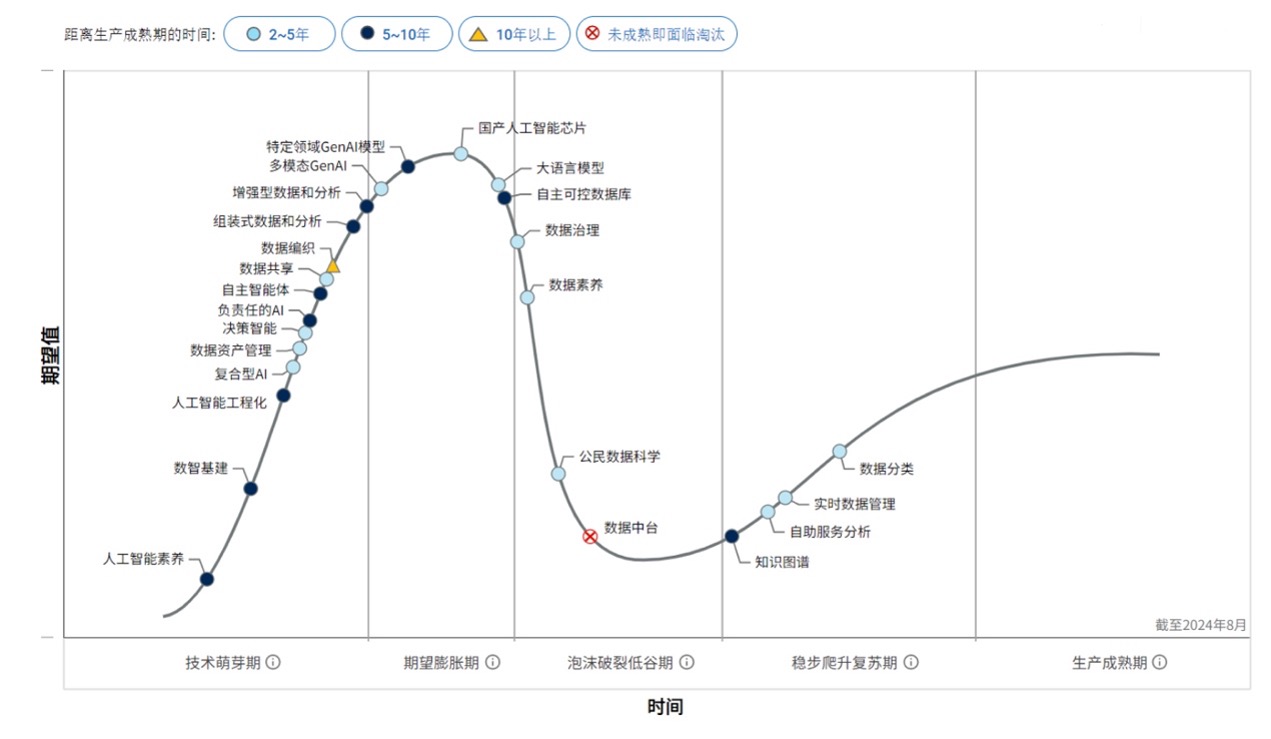

Gartner发布的《2024年中国数据、分析和人工智能技术成熟度曲线》显示,国产人工智能芯片正处于期望膨胀期。根据这一解析,国产AI芯片之后将进入泡沫破裂低谷期,然后才能到稳步爬升复苏期。

来源:Gartner《2024年中国数据、分析和人工智能技术成熟度曲线》

陈巍表示,这一过程符合国内产业发展的特点,即:先投入较多资源在短时间快速形成多家头部企业,然后再通过竞争、并购的方式优选出能够跟世界巨头竞争的企业,这有利于产业在短期成长起来。

另一方面他强调了新的可能性,由于Gartner曲线是根据已知预测未知,但集成电路产业的技术也在不断前进,不管是新的视频大模型技术、3D集成技术和CPO等光互连技术,其发展曲线目前看起来都超越了Gartner曲线,在几种新技术的推动下,国产AI芯片仍有不断前进的可能,且现在应该开始注重生态和客户TOC,逐渐从芯片视角转向生态和需求视角。

信晓旭谈到,泡沫破裂是技术创新的必经阶段,标志着技术成熟和市场筛选的开始。随着AI大模型升级和生成式AI的广泛应用,国产AI芯片迎来发展窗口期,大模型向边缘和端侧设备下沉的趋势,使其更具生命力。国产AI芯片需在性能突破和产业链协同上抢占先机,提供高性价比、高能效比、易用性强的芯片。具体变化包括:从数据中心扩展到端边的应用场景多元化;大模型普及对计算效率和算法优化要求更高,推动存算一体等创新技术融合加速;国产AI芯片要和软硬件、应用等环节协同,形成合力突破。

鲍敏祺谈到,事物发展的普遍规律是螺旋式上升、波浪式前进。比如应用最为广泛的免费语言类模型,目前已经有很多用户会安装豆包、Kimi等智能问答型App。此外,很多证券分析平台、社交平台等已经植入了智能Copilot产品,这代表着新一轮生成式AI浪潮并不仅仅是AI算法的一路高歌猛进,还伴随着一些商业模式的实践和验证。

因此,AI芯片的发展并非毫无支撑,也非泡沫,或许之后会迎来市场充分竞争下的行业洗牌,但相信不会出现断崖式下跌的情况。

此外,他认为AI芯片存在外循环和内循环。一是目前受地缘政治影响,芯片和AI领域的全球供应体系遭遇挑战,国产替代成为主流,为国内AI芯片提供了一定的发展机遇。二是国内在如AI PC、AI手机、智驾智舱等新兴应用领域呈现出蓬勃的发展前景,这无疑也为AI芯片的高质量发展提供了雄厚的产业支撑。

不可否认,目前国内AI芯片面临着诸如产品同质化和部分性能不如预期等挑战,但长期来看,整体需求体量不会“硬着陆”。市场在经过大浪潮沙和资源整合后,那些经历过优胜劣汰而生存下来的企业将成为未来本土AI发展的重要力量。

写在最后

国产AI芯片的发展历程中,“泡沫破裂”似乎是一个难以回避的阶段。特别是个别企业的市场表现引发了市场对AI芯片的担忧。然而,这也并非全然是负面现象,更像是技术创新和市场筛选的必经之路。

即便如此,我们仍需看到国产AI芯片的广阔前景。随着AI技术的不断普及和应用场景的拓展,市场对高性能、低功耗AI芯片的需求将持续增长。特别是在云计算、数据中心和边缘计算等领域,国产AI芯片有望凭借技术突破和产业链协同,逐步实现国产替代和突破,最终走向成熟并实现大规模应用。

来源: 与非网,作者: 张慧娟,原文链接: https://www.eefocus.com/article/1797465.html

芯耀

芯耀

2878

2878