自2012年以来,大规模的AI训练所使用的数据集的计算量正以每年10倍的速度在增长。以ChatGPT为例,其在2022年11月的版本使用的参数是1750亿个,而到了今年3月的版本使用的参数则达到了1.5万亿个。

为什么训练参数量越来越多,其背后的原因主要有三点:1、日益复杂的AI模型;2、大量可以被用于训练的在线生成数据;3、人工智能应用对准确性和稳健性期望的持续提升。当我们把这些需求转化为对内存的需求时,就意味着需要更高的带宽,以及更高的容量。

事实上,当前算力向前演进可能不会有太多的挑战,摆在业界面前更多的是存储墙的问题,也就是内存、带宽发展太慢了。这也就是为什么英伟达在GPU架构无需调整的情况下,能让H200推理速度达到了前代产品H100的两倍主要原因。据悉,得益于HBM3e的搭载,H200显卡拥有141GB的内存和4.8TB/秒的带宽。

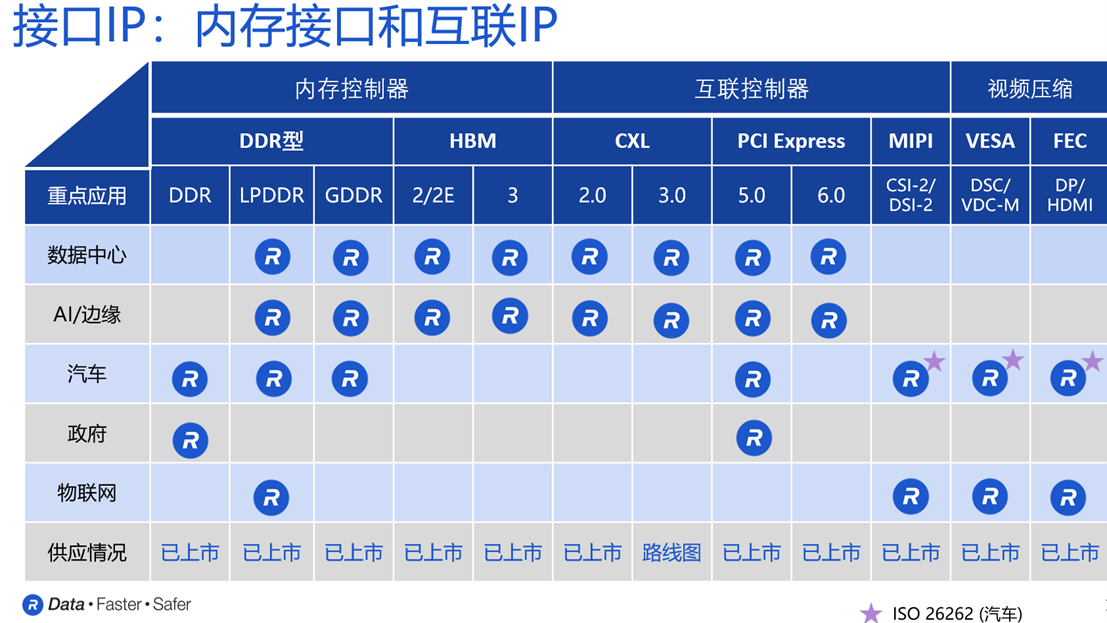

图 | 内存接口和互联IP,图源:Rambus

需求最终的表现会在市场,根据TrendForce发布的数据显示,2023年,AI行业主流需求已经从HBM2E转向HBM3,HBM3需求占比提升至39%,预计2024年市场需求占比将达60%。而与非网记者也在Rambus接口IP产品管理和营销副总裁Joe Salvador处证实了这一点。

说到内存、接口,我们不得不提到一家把存储基因刻在名字中的企业——Rambus(Ram和bus分别代表存储和安全快速传输)。

这家企业成立于上个世纪的九十年代,总部位于硅谷的圣何塞,其主要业务包括:基础专业授权、半导体IP授权和芯片业务。其中半导体IP又主要分为接口IP和安全IP。Rambus的技术和产品面向数据中心和边缘计算市场,以及汽车物联网等细分市场。

根据Rambus发布的财报显示,2022年公司来自于芯片和IP的业务收入再创新高,其中来自产品的业务收入同比实现了58%的增长,同时经营现金流达到了2.3亿美金。

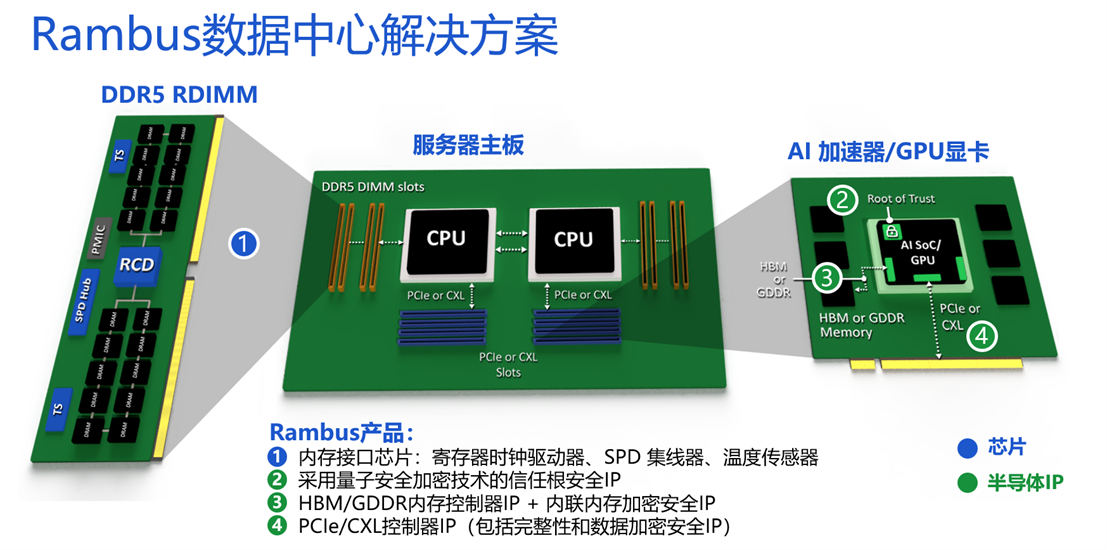

图 | Rambus数据中心解决方案,图源:Rambus

Rambus能在2022年拥有如此亮眼成绩的背后,是因为数据中心是其主要聚焦的市场,75%以上的芯片和IP业务收入都来自于数据中心。而近年来,数据中心赛道在大数据、人工智能、物联网等行业需求的共同驱动下,发展迅速,且表现出持续性的增长趋势。

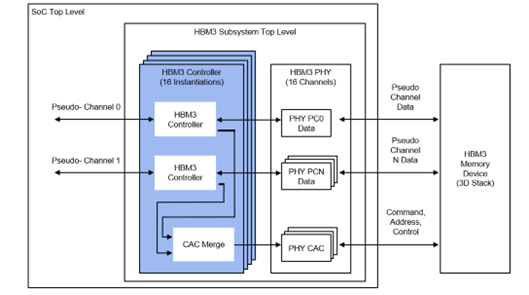

在这样的大背景下,Rambus于近日推出了HBM3内存控制器IP,可提供高达9.6 Gbps的性能,可支持HBM3标准的持续演进。相比HBM3 Gen1 6.4 Gbps 的数据速率,Rambus HBM3内存控制器的数据速率提高了50%,总内存吞吐量超过1.2 TB/s,适用于推荐系统的训练、生成式AI以及其他要求苛刻的数据中心工作负载。

图 | Rambus HBM3控制器模块图

据悉,Rambus HBM3内存控制器从即日起便可提供许可证。

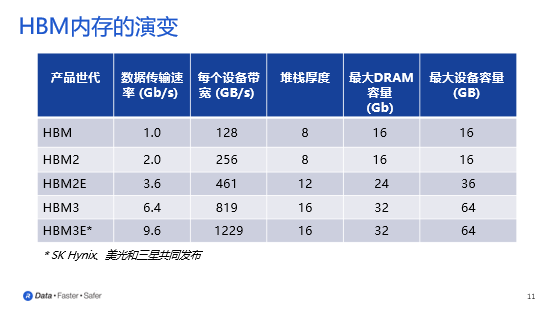

而对于Rambus HBM3内存控制器是否能够满足市场上新推出的HBM3e需求,Joe Salvador认为:“确实,当前市场上几家主流的内存厂商都宣称有HBM3e内存,但从规格的角度上来讲,目前所说的HBM3e还不是正式的行业标准,它是在HBM3基础上的拓展,比较HBM3E和HBM3,可以发现其实堆栈的厚度没有变化,支持的DRAM容量也没有变化,变化的知识总带宽。”

图 | HBM内存的演变,图源:Rambus

值得一提的是,Rambus前段时间将自己发展得非常好的PHY业务出售给了自己曾经的客户Cadence,针对这一战略性变化,Joe Salvador表示:“这一动作可以帮助Rambus更好地去跟其他的PHY合作伙伴合作,因为已经不构成跟他们直接的竞争关系了,而是成为很好的上下游的合作伙伴关系。”

此外,针对中国市场,Rambus大中华区总经理苏雷表示:“今年以ChatGPT为代表的AIGC的发展,彻底带火了AI芯片。我们看到在中国市场上也有一些新兴公司,开始聚焦在AI训练芯片上,当前我们正在跟这些云厂商、AI芯片公司进行紧密地合作,今年主要是面向HBM3的项目。”

芯耀

芯耀

2751

2751

下载ECAD模型

下载ECAD模型

[课程]STM32电机控制软件开发软件X-CUBE-MCSDK 6x介绍

[课程]STM32电机控制软件开发软件X-CUBE-MCSDK 6x介绍