ChatGPT已经从下游AI应用“火”到了上游芯片领域,在将GPU等AI芯片推向高峰之外,也极大带动了市场对新一代内存芯片HBM(高带宽内存)的需求。据悉,2023年开年以来三星、SK海力士的HBM订单就快速增加,价格也水涨船高。有市场人士透露近期HBM3规格DRAM价格上涨了5倍。这也为寒冬中的存储器市场带来了一抹春色。

ChatGPT爆红提升HBM需求

作为一款自然语言类AI应用,ChatGPT不仅对芯片算力有着巨大需求,对内存技术的需求也极高,比如ChatGPT上线应用以来,拥有高速数据传输速度的HBM内存芯片几乎成为ChatGPT的必备配置,市场需求激增。有消息称,2023年开年以来三星、SK海力士HBM订单就快速增加,价格也水涨船高。

有市场人士透露英伟达已经将SK海力士的HBM3安装到其高性能GPU H100上,而H100已开始供应ChatGPT服务器所需。近期最新一代高带宽内存HBM3的价格上涨了5倍。

SK海力士HBM设计团队项目负责人朴明宰撰文介绍,HBM是一种可以实现高带宽的高附加值DRAM产品,适用于超级计算机、AI加速器等对性能要求较高的计算系统。随着计算技术的发展,机器学习的应用日渐广泛,而机器学习的基础是自20世纪80年代以来一直作为研究热点的神经网络模型。作为速度最快的DRAM产品,HBM在克服计算技术的局限性方面发挥着关键的作用。

此前,尽管HBM具有出色的性能,但与一般DRAM相比,其应用较少。这是因为HBM需要复杂的生产过程,平均售价至少是DRAM的三倍。但AI服务的扩展正在扭转这样的局面。据悉,目前已经有超过25000块英伟达计算卡加入到了深度学习的训练中。未来,随着不断接入ChatGPT等生成式AI需求大增,HBM的需求也将呈现出暴增的态势。三星内存副总裁Kim Jae-joon便指出,ChatGPT等基于自然语言技术的交互式AI应用的发展有利于提升内存需求。高效且大量的运算能力、高容量的内存,是AI学习与推论模型的根基。

存储巨头齐争高性能市场

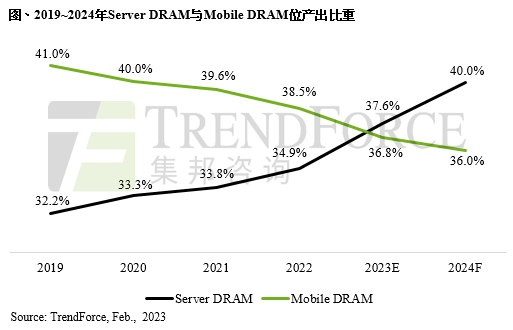

去年以来,受消费电子产品需求下滑等多种因素影响,存储行业进入了下行周期。SK海力士全年的净利润降至2.4万亿韩元,同比下滑75%。三星电子存储业务的营收与营业利润,在去年第三季度和第四季度也是同比环比双双下滑。TrendForce集邦咨询预估2023年第一季度DRAM价格仍将持续下探。其中,PC及服务器用DRAM跌幅仍是近两成。HBM的需求火爆不啻于一剂“强心针”。这种情况下,SK海力士、三星电子、美光等内存厂商均表示将致力于HBM的开发。企业之间的产品开发竞争也随之升温。

2013年SK海力士将TSV技术应用于DRAM,在业界首次成功研发出第一代HBM芯片。此后,SK海力士相继推出HBM2、HBM2E、HBM3数代产品。据悉,SK海力士正在研发HBM4,预计新一代产品将能够更广泛地应用于高性能数据中心、超级计算机和AI等领域。SK海力士CFO金祐贤表示,公司正关注着市场上出现以AI为基础的新服务器替换存储器需求的积极信号。公司计划持续投资DDR5/LPDDR5、HBM3等主力产品的量产和未来高成长领域。

三星电子虽然在HBM的开发上落后一步,但也在寻找新的突破口。据悉,三星电子正在开发集成AI处理器新一代存内计算芯片HBM-PIM。北京大学信息科学技术学院微纳电子学系副教授叶乐表示,存内计算芯片是将AI引擎引入存储库,将处理操作转移到HBM本身,将有效加大数据传输带宽,提高内存的处理速度。存内计算技术正在实现产品化。目前基于SRAM的存内计算,已经进入到产品化的前夜,DRAM存内计算适用于大算力AI芯片,因此还需要解决其他一系列的技术难题。

上下游发力抢占先机

与HBM相关的上下游企业也在发力,以期抢占先机。AMD在HBM的诞生与发展过程中功不可没。最早是AMD意识到DDR的局限性并产生开发堆叠内存的想法,其后与SK海力士联手研发了HBM,并在其Fury显卡采用全球首款HBM。ISSCC 2023国际固态电路大会上的消息,AMD考虑在Instinct系列加速卡已经整合封装HBM高带宽内存的基础上,在后者之上继续堆叠DRAM内存,可以在一些关键算法内核可以直接在整合内存内执行,而不必在CPU和独立内存之间往复通信传输,从而提升AI处理的性能,并降低功耗。

英伟达同样重视处理器与内存间的协同,一直在要求SK海力士提供最新的HBM3内存芯片。据悉,目前已经有超过25000块英伟达计算卡加入到了深度学习的训练中。如果所有的互联网企业都在搜索引擎中加入ChatGPT这样的机器人,那么计算卡以及相应的服务器的需求量将会达到50万块,也将连同带动HBM的需求量大幅增长。

IP厂商亦已先行布局HBM3。去年,Synopsys推出首个完整的HBM3 IP解决方案,包括用于2.5D多芯片封装系统的控制器、PHY(物理层芯片)和验证IP。HBM3 PHY IP基于5nm制程打造,每个引脚的速率可达7200 Mbps,内存带宽最高可提升至921GB/s。Rambus也推出支持HBM3的内存接口子系统,内含完全集成的PHY和数字控制器,数据传输速率达8.4 Gbps,可提供超过1TB/s的带宽。

Rambus IP核产品营销高级总监Frank Ferro此前在接受采访时指出,HBM现在依旧处于相对早期的阶段,其未来还有很长的一段路要走。而可预见的是,随着越来越多的厂商在AI和机器学习等领域不断发力,内存产品设计的复杂性正在快速上升,并对带宽提出了更高的要求,不断上升的宽带需求将持续驱动HBM发展。

1270

1270

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)