近年来,深度学习技术在涉及高维非结构化数据领域展现出了最先进的性能,如计算机视觉、语音、自然语言处理等方面,并且开始涉及更大、更复杂的多模态信息问题。

不同传感器在进行同一实验任务时,针对产生的同一现象进行观测,采集的数据构成被测对象的多模态信息。多模态信息可以实现不同传感器之间数据互补,并在相同学习任务获取更丰富的特征,从而实现比单一模态更好的性能。

在自动驾驶领域,多模态数据通常包括安装在车辆上的多个传感器,包括雷达、立体可见光摄像头、红外摄像头、GPS等,为执行自动巡航,从传感器收集的异构数据用于学习许多相互关联但复杂的任务,如定位和测绘、场景识别、路径规划和驾驶员状态识别等。

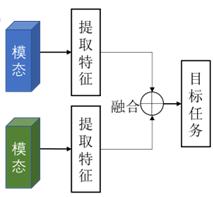

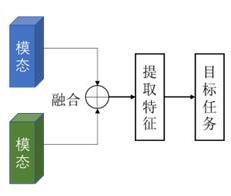

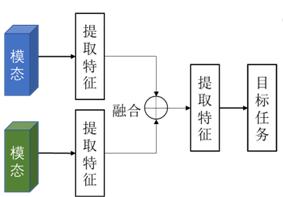

大多数先进的融合方法集中于如何融合来自多模态空间的信息或特征。根据多模态信息的融合策略主要可以分为早期融合、中期融合和晚期融合。

多传感器数据融合处理方法

早期融合在输入端进行简单链接多模态数据组合,然后输入到特定的模型进行处理。LaserNet采用了这种融合策略,将三维的点云映射到二维图像上,采用全卷积网络进行概率预测,实现端到端的三维物体检测。

早期融合的方式能够保留最多原始数据的特征,但对于来自不同传感器的模态信息来说,这种融合方式计算量大,对设备运行要求较高。

中期融合又称作是特征融合,需要对来自不同模态的数据进行特征提取,并对特征图进行融合操作后输入到目标任务中进行处理。通过ROI池化的方式将二维图像和点云鸟瞰图、前视图特征整合到同一特征尺度进行融合,并构建两个子网络进行多视图区域特征融合,并在不同路径中间层中交互特征,实现了自动驾驶场景下高精度的三维物体检测。

中期融合的方式能够有效减少模型的数据输入,能够有效整合来自不同模态的深层特征。

晚期融合(决策融合)针对每种模态的目标任务结果进行决策投票,比其他两种融合策略更为直观,能够有效地促进多模态之间的协作,避免因为传感器失效而对最终任务结果造成严重影响。

晚期融合由于需要对不同模态的数据进行处理和任务执行,其任务完成质量受到单一模态影响较大,同时也存在计算开销大的问题。

雅名特aiSim仿真模拟平台

作为一款端到端的自动驾驶仿真模拟工具,雅名特aiSim仿真模拟平台能够提供现实世界中难以捕捉的场景和自动驾驶过程中的边缘案例,具有高可扩展性、高保真度的传感器模拟和环境模拟,能够扩充不同测试场景的数据广度和深度,有效提升ADAS/AD算法的能力。

传感器是环境感知系统的核心,自动驾驶车辆需要通过传感器获知周围的环境信息。雅名特aiSim设计了基于物理原理的传感器模型,能够全面准确的模拟条件和交互环境。传感器模型库包括相机、激光雷达、雷达、超声波传感器等。

- 高度可扩展框架能够实现在多个GPU上实现分布式光追渲染,实时仿真高度复杂的多传感器配置。

- 具有污泥遮挡、冷凝水雾遮挡、镜头色差、镜头炫光等多种相机退化和镜头失真情景。

- 支持新传感器模型配置和设计,并快速测试其感知性能。相机、激光雷达和雷达视场可视化有助于确定传感器在车辆上的最佳安装位置。

了解雅名特自动驾驶更多技术干货/产品及解决方案,欢迎前往【雅名特自动驾驶】官方网站:https://aimotek.com/

联系我们:13600014972

企业微信:https://tl-tx.dustess.com/OdM1ZZz672

芯耀

芯耀

1812

1812

下载ECAD模型

下载ECAD模型