AI 正在利用一系列广泛的神经网络来解决范围同样广泛的商业挑战,这也意味着,出色的 AI 推理加速器不仅要具备出色的性能,同时还要具备通用性来加速这些神经网络。

为什么需要通用性?

在一个AI 应用中,用户通常会用到许多不同类型的神经网络,甚至可能每个步骤都要用到不同类型的 AI 模型。例如,可能需要理解用户的语音请求、对图像进行分类、提出建议,然后以人声作为语音信息提供回应。因此,在多个不同的主流模型上保持领先性能、具备较为广泛的通用性,往往会成为用户考虑的关键所在。

MLPerf 是由来自学术界、研究实验室和相关行业的 AI 领导者组成的联盟,旨在“构建公平和有用的基准测试”,在规定的条件下,针对硬件、软件和服务的训练和推理性能提供公平的评估。为确保始终站在行业趋势的前沿,MLPerf 也在不断演进,定期进行新的测试并添加代表AI领域当前水平的新工作负载。

目前,MLPerf 基准测试涵盖了流行的 AI 工作负载与场景,比如计算机视觉、自然语言处理、推荐系统、语音识别等,其透明性和客观性在业内广受认可,得到了包括亚马逊、Arm、百度、谷歌、哈佛大学、英特尔、Meta、微软、斯坦福大学和多伦多大学在内的支持。

NVIDIA H100 GPU创造多项世界纪录

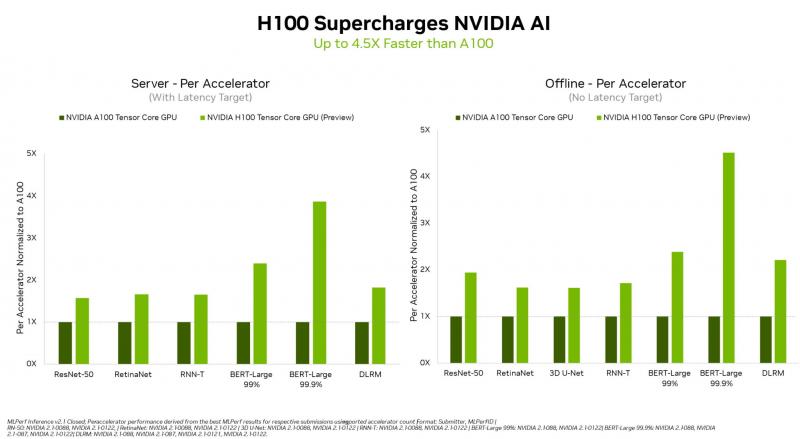

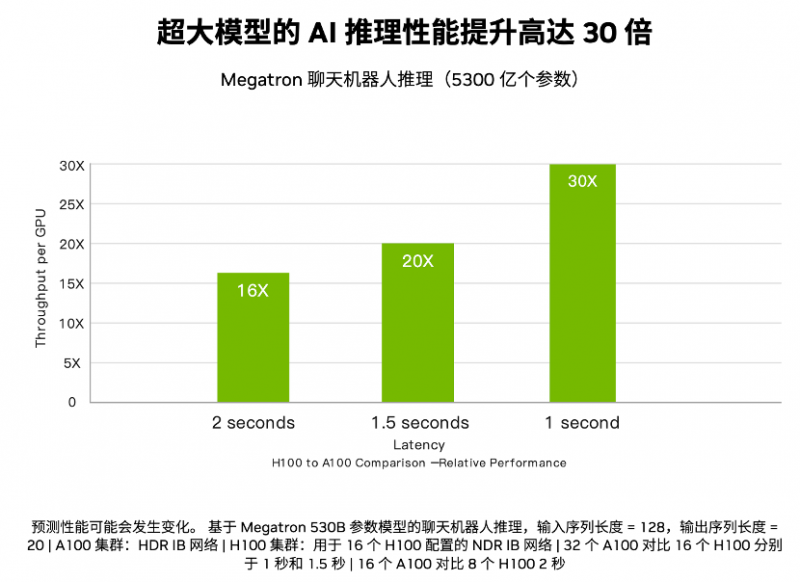

在最新进行的MLPerf 行业标准 AI 基准测试中,首次亮相的 NVIDIA H100 Tensor Core GPU在所有工作负载推理中都创造了世界纪录,它在单个服务器和离线场景中展现出吞吐量和速度方面的领先优势,并且性能比上一代 GPU 高出 4.5 倍。

NVIDIA H100 GPU 在数据中心类别的所有工作负载上都树立了新标杆

BERT是MLPerf AI模型中规模最大、对性能要求最高的的模型之一,多用于自然语言处理,而H100在BERT 模型上表现出色,则要部分归功于 Transformer Engine。

首先,H100的第四代 Tensor Core 可加速所有精度(包括 FP64、TF32、FP32、FP16 和 INT8),其次,Transformer 引擎可结合使用 FP8 和 FP16 精度,减少内存占用并提高性能,同时仍能保持大型语言模型的准确性。

这是H100 GPU首次公开亮相,它将于今年晚些时候上市。在数据中心级部署 H100 GPU,可以使研究人员能使用新一代百亿亿次级 (Exascale) 高性能计算 (HPC) 和万亿参数的 AI。据透露,H100还将参加未来的 MLPerf训练基准测试。

A100 GPU 持续展现领先优势

在最新测试中,NVIDIA A100 GPU 继续在主流 AI 推理性能方面展现出全方位领先。目前,主要的云服务商和系统制造商都采用了NVIDIA A100 GPU。

自 2020 年 7 月在 MLPerf 上首次亮相以来,由于 NVIDIA AI 软件的不断改进,A100 GPU 的性能已经提升了6倍。在数据中心和边缘计算类别与场景中,A100 GPU赢得的测试项超过了其他提交的结果。A100还在6月的MLPerf训练基准测试中取得了全方位的领先,展现了其在整个AI工作流中的能力。

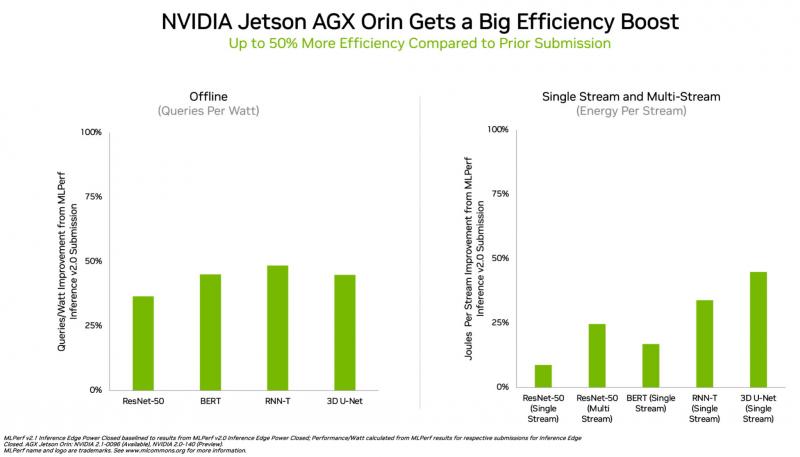

Orin 在边缘计算领域保持领先

在边缘计算方面,NVIDIA Orin 运行了所有 MLPerf 基准测试,是所有低功耗系统级芯片中赢得测试最多的芯片。并且,与 4 月在 MLPerf 上的首次亮相相比,其能效提高了50%。

在上一轮基准测试中,Orin 的运行速度和平均能效分别比上一代 Jetson AGX Xavier 模块高出 5 倍和 2 倍。

在能效方面,Orin 边缘 AI 推理性能提升多达 50%

Orin将NVIDIA Ampere架构 GPU 和Arm CPU 内核集成到一块芯片中。目前,Orin 现已被用在 NVIDIA Jetson AGX Orin 开发者套件以及机器人和自主系统生产模块,并支持完整的 NVIDIA AI 软件堆栈,,包括自动驾驶汽车平台(NVIDIA Hyperion)、医疗设备平台(Clara Holoscan)和机器人平台(Isaac)。

广泛的AI 生态系统

得益于在以上产品中的持续投入,NVIDIA AI 成为唯一能够在数据中心和边缘计算中运行所有 MLPerf 推理工作负载和场景的平台。

MLPerf 结果也显示,NVIDIA AI 得到了业界广泛的机器学习生态系统的支持。在这一轮基准测试中,有超过 70 项提交结果在 NVIDIA 平台上运行。例如,Microsoft Azure 提交了在其云服务上运行 NVIDIA AI 的结果。此外,10 家系统制造商的 19 个NVIDIA 认证系统参加了本轮基准测试,包括华硕、戴尔科技、富士通、技嘉、慧与、联想、和超微等。它们的结果表明,无论是在云端还是在自己数据中心运行的服务器中,用户都可以借助 NVIDIA AI 获得出色的性能。

据介绍,合作伙伴之所以参与 MLPerf ,是因为他们知道这是一个为客户评估 AI 平台和厂商的重要工具。最新一轮结果也确实证明,NVIDIA向用户提供的性能在随着平台的发展而增长。

写在最后

AI的复杂性要求平台的各个方面实现紧密结合。正如 MLPerf 基准测试中所展现的,需要全栈的创新来获得性能领先。NVIDIA通过GPU、可扩展的互连技术以及软件配备(一种端到端解决方案,可在数据中心、云或边缘部署,并可提供出色结果),实现了出色的性能。

软件在整体AI平台中的重要性不容忽视,NGC是 NVIDIA 平台和 MLPerf 训练和推理结果的重要组成部分,是适用于GPU优化 AI、HPC和数据分析软件的中心,可简化和加速端到端工作流程。凭借 150 多个企业级容器(包括适用于对话式 AI 和推荐系统的工作负载)、100 多个模型,以及可在本地、云或在边缘部署的行业特定 SDK,NGC可助力数据科学家、研究人员和开发者快速构建强大的解决方案,快速提供业务价值。

芯耀

芯耀

1551

1551

下载ECAD模型

下载ECAD模型

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.png?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

[课程]STM32电机控制软件开发软件X-CUBE-MCSDK 6x介绍

[课程]STM32电机控制软件开发软件X-CUBE-MCSDK 6x介绍