本周内最新发布的MLPerf 基准测试结果,英伟达及其合作伙伴提供了亮眼的整体AI训练性能。共有 16 家合作伙伴使用 NVIDIA AI 平台提交了本轮结果,包括华硕、百度、中国科学院自动化研究所、戴尔科技、富士通、技嘉、新华三、慧与、浪潮、联想、宁畅和超微。这一参赛阵容约占所有参赛生态伙伴的90%。

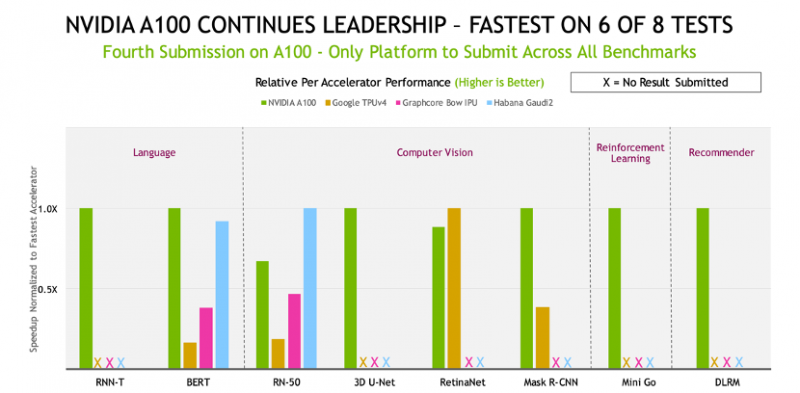

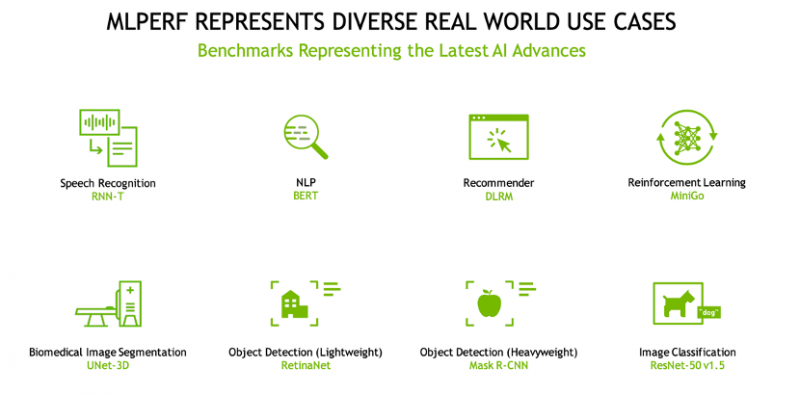

MLPerf作为行业标准AI基准测试,代表了流行的AI用例,包括语音识别、自然语言处理、推荐系统、目标检测、图像分类等。此次,英伟达AI平台覆盖了 MLPerf 训练 2.0 版本的所有八项基准测试,这也是唯一一个运行了所有基准测试的加速平台,突显了平台的通用性。

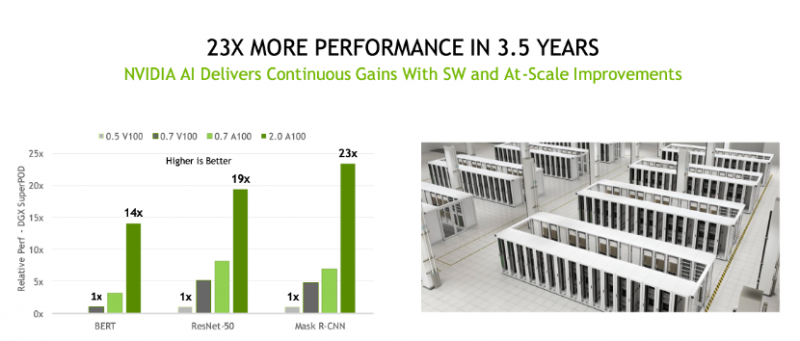

3年半内性能提高 23 倍

MLPerf基准测试诞生于2018年12月,英伟达也正是在这时向MLPerf提交了首轮测试结果。伴随着MLPerf基准的演进,英伟达AI平台在 3 年半时间内,通过跨GPU、软件和大规模改进的全栈式创新,在基准测试中实现了 23 倍的性能提升。

也正是这种飞跃式的创新突破,给了用户对其AI平台提供持续服务和优化能力的信心,使得用户投资的AI平台能够持续服务3至5年,并持续推进以适配最先进的技术。预计英伟达于今年3月发布的Hopper架构,有望在未来的 MLPerf 基准测评中继续实现性能飞跃。

领先的基准测试结果与可用性

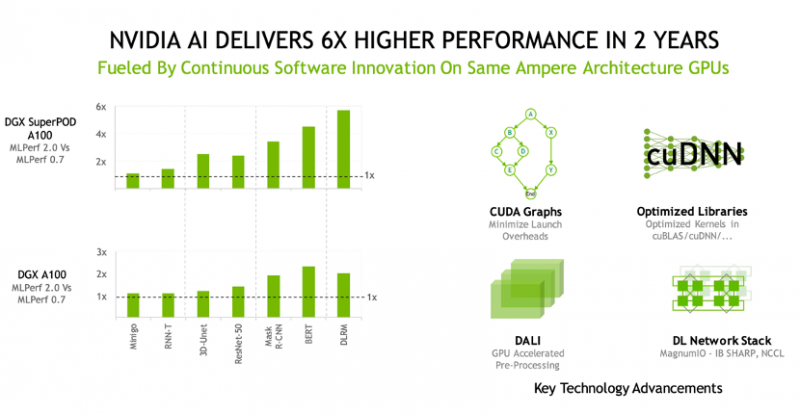

在连续第四次 MLPerf 训练提交结果中,基于Ampere架构的NVIDIA A100 Tensor Core GPU 依然表现出色,“优势周期”可以说非常长了。此外,A100在八项测试的六项中呈现了最快的速度,A100 还保持了单芯片性能的领导地位。

各个提交者平台在每个网络的“最快训练时间”

Selene是英伟达内部的AI超级计算机,它基于模块化的 NVIDIA DGX SuperPOD,并由A100 GPU、软件堆栈和NVIDIA InfiniBand 网络驱动,在八项大规模工作负载测试的四项中获得 “最快训练时间”。

注:为了计算单芯片性能,该图表将每份提交结果归一化到每个提交者最常见的尺度,检测分数归一化到速度最快的竞争者,最快竞争者显示为 1倍。

为什么驱动AI应用需要平台通用性?

英伟达AI平台是此次唯一一个运行了MLPerf 训练 2.0 版本的全部八项基准测试的加速平台,据了解,这八项测试覆盖了真实物理世界的多样化应用案例,也从一定程度上说明了英伟达AI平台的通用性。

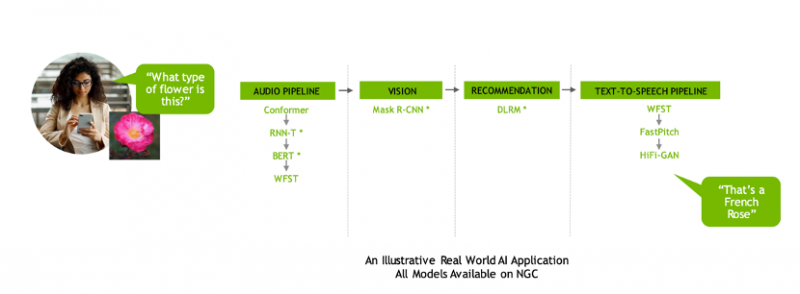

为什么驱动AI应用需要平台通用性?以下图这个较为简单的用例来看:AI应用可能需要理解用户说出的要求,对图像进行分类、提出建议并以语音信息的形式作出回应。而这些任务需要多种类型的 AI 模型按顺序工作,用户需要能够快速且灵活地设计、训练、部署和优化这些模型。

如果平台具备通用性,能够在MLPerf 及其他版本中运行每个模型,则具备了将现实世界的AI引入入生产的关键。

对于客户而言,在部署AI的总成本中,AI基础设施本身的成本占比相对较少,而数据科学团队的成本占比很重。也就是说,数据科学和工程团队是当前最宝贵的资源,因为他们的生产力决定了 AI 基础设施的投资回报。

对于AI 研究人员来说,他们的生产力取决于能否快速测试新的想法,而这需要通用性来训练任何模型,以及大规模训练模型所能提供的速度。正因如此,企业用户应该关注单位成本的整体生产力,以确定最合适的 AI 平台。

通过英伟达AI平台,客户可以在整个 AI 流程中使用相同的基础设施,利用它来适配数据准备、训练和推理之间的不同需求,这极大地提高了利用率,也实现了较高的投资回报率。

另一方面,尽可能延长AI 基础设施使用寿命,也是有效较低总体拥有成本的关键。那么,如何能尽可能延长基础设施的寿命?对于最新模型创新的支持是关键,这就对AI平台的兼容性、扩展性提出了更高要求。英伟达AI 平台兼容并适用于每个模型、可以扩展到任何规模,并加速从数据准备到训练再到推理的端到端 AI 流程,能够实现最高的单位成本生产力。

写在最后

自MLPerf问世以来,英伟达持续跟进在训练、推理、HPC等各方面的基准测试和评测。通过跨硬件、软件和网络的全栈改进,其AI平台的性能在持续释放。

除了硬件本身的升级,软件的持续创新也是关键。例如,在提交结果中大量使用的 CUDA Graphs,该软件可以最大限度地减少跨多个加速器上运行作业的启动开销。不同库的内核优化,如 cuDNN 和预处理库 DALI,解锁了额外的加速。英伟达Magnum IO 和 SHARP,通过将部分AI功能卸载到网络中,可以获得更好的性能,特别是在大规模情况中。

值得一提的是,英伟达所使用的所有软件都可以从 MLPerf 资源库中获取,这种开放的成果共享也将为AI的发展和应用带来推进作用。

1065

1065