英伟达一边忙着打造性能强悍的计算平台,一边已经预见了生成式AI业务部署所面临的巨大挑战。如果说Blackwell是英伟达为了未来万亿参数AI大模型所创造的全新的硬件计算方式,那么软件方面,NIM推理微服务有望为英伟达开启新的发展篇章,进一步筑牢、筑深它在人工智能领域的领导地位。

日前,英伟达也发布了最新预训练、可定制的AI工作流目录NVIDIA NIM Agent Blueprints,这进一步提升了NIM的能力。通过NIM Agent Blueprints,开发者能够迅速开始创建使用一个或多个AI智能体的AI应用。目前英伟达共推出3个NIM Agent Blueprints,包括适用于客户服务的数字人工作流、适用于计算机辅助药物研发的生成式虚拟筛选工作流,以及适用于企业检索增强生成(RAG)的多模态PDF数据提取工作流,企业可以根据用户反馈不断完善其AI应用,形成一个数据驱动型的AI飞轮。据悉,英伟达未来将计划推出更多新的NIM Agent Blueprints,助力企业打造属于自己的AI。

弥合生成式AI与企业落地之间的鸿沟

以ChatGPT为代表的AI大模型还在变得越来越庞大。一方面,要学习的东西还很多,另一方面,它可以学习的方式和渠道在变多:它可以从文字、图像和视频中学习,可以通过合成数据学习,也可以通过强化学习的方式学习……随着时间推移,这些模型变得越来越复杂。

当企业把它们转向大规模的生产部署时,这其中的工作包括将AI模型连接到企业现有的基础设施,需要优化系统延迟和吞吐量、监控和安全性等等,开发生成式AI应用还涉及到数据的预处理、模型推理和后处理……这是一个既复杂又耗时的过程,涉及到专门的技能、平台和流程等等。

为了简化生成式AI的部署,弥合复杂的AI开发环境与企业运营需求之间的差距,英伟达今年推出了一款可加速AI部署且易于使用的工具——NVIDIA NIM推理微服务。它可以将模型作为经过优化的容器提供,以便在云端、数据中心、工作站、台式电脑和笔记本电脑中部署模型。每个NIM容器都包含经过预训练的AI模型和所有必要的运行时组件,可让用户轻松地将AI功能集成到应用中,实现显著的效率提升。

什么是NVIDIA NIM推理微服务?

剖析AI应用的基础模组来看,微服务已经成为了一种强大的架构,从根本上改变了人们设计、构建和部署软件的方式。它的可扩展性、增强的模块化属性和灵活性,特别适用于开发生成式AI应用,能够让这些资源密集型组件实现高效扩展,同时避免对整个系统产生影响。

不同于传统软件的一体化架构,将一个应用内所有功能和服务都“锁”在一起,微服务架构是一种模块化的思路,它可以将应用分解为一系列可独立部署的松散耦合服务。每个服务都负责一项特定的功能,并通过明确定义的应用编程接口(API)与其他服务通信。这样一来,不仅便于开发人员更加轻松地管理和优化这些服务,还可以根据需求独立扩展服务,从而优化了资源利用率并提高系统的整体性能。

NVIDIA NIM推理微服务本质上就是这样的构建原理,它是一套经过优化的云原生微服务,把所有软件都集成到一个容器中,包含行业标准API、特定领域的代码、优化的推理引擎等等,创造了用收发请求来进行软件开发的新方法。

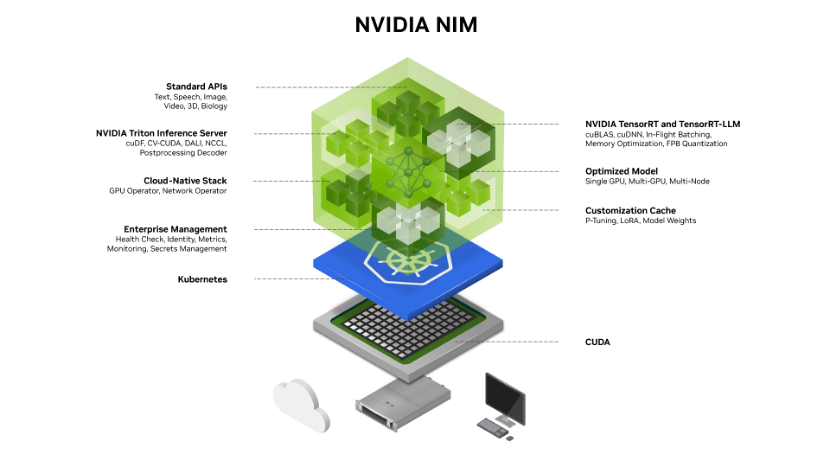

根据NIM推理微服务的技术架构概览图(下图),可以看到NIM作为NVIDIA AI Enterprise的一部分,支持在生产环境中部署AI应用,它为用户提供了预先配置好的容器化环境和Kubernetes部署工具,以便快速部署和管理AI模型。开发者可以通过符合每个领域行业标准的API访问AI模型,这些API与生态系统中的标准部署流程兼容,开发者能够快速更新其AI应用 (通常只需3行代码)。这使得开发者无需大量定制或专业知识,就能够将NIM集成到其现有应用程序和基础设施中。

来源:英伟达官网

NIM可用于GPU加速推理,其中包括NVIDIA CUDA软件、NVIDIA Triton推理服务器和NVIDIA TensorRT-LLM软件。其无缝集成和易用性有助于在企业环境中快速部署和扩展AI解决方案,在帮助企业快速地将AI集成到其业务流程中的同时,依然保持高度的灵活性和扩展性。

对于生成式AI应用覆盖的特定领域,比如语言、语音、视频处理、医疗健康等,NIM还包含了特定的NVIDIA CUDA库,以及针对这些领域量身定制的专用代码,以确保应用程序准确无误并与其特定用例相关。

为了在加速基础设施上提供尽可能好的延迟和吞吐量,NIM针对每个模型和硬件设置优化了推理引擎,从而降低了在扩展推理工作负载时的成本,并改善了最终用户体验。同时,为了保证数据的安全性、同时实现更高的模型准确性和性能,NIM支持开发者使用从未离开数据中心边界的专有数据源,来对模型进行对齐和微调。

生成式AI应用通常涉及多个步骤,例如数据预处理、模型推理和后处理。借助NIM,每个步骤都可以独立开发、优化和扩展。此外,随着AI模型和技术的快速发展,NIM可使集成新模型及替换现有模型的过程变得更加轻松,同时不会中断整个应用的运行。

为无数部署生成式AI的企业打开入口

NIM带来了哪些直接好处?对于企业生产应用来说,它简化了模型的集成和部署过程,能够兼顾灵活性;对开发者来说,它提供了一种具有变革性的开发方法,使得开发者可以专注于构建应用,而无需担心数据准备、模型训练或自定义过于复杂,使得copilots、聊天机器人等构建生成式AI应用时,所需时间从数周缩短至几分钟。

借助NIM,企业可以优化其AI基础架构,以更大限度地提高效率和成本效益,而无需担心 AI模型开发的复杂性和容器化。在加速AI基础架构的基础上,NIM有助于提高性能和可扩展性,同时降低硬件和运营成本。

这就相当于,为开发AI驱动的企业应用程序和在生产中部署AI模型提供了一条非常简化的路径,给无数想要部署生成式AI的企业打开了一个入口,使得他们能够通过易于使用的界面,体验各种AI模型和应用,并在企业平台上创建和部署自定义应用。

NIM还可使企业最大限度利用其基础设施投资。例如,相较于未使用NIM的情况下,在NIM中运行Meta Llama 3-8B时,后者在加速基础设施上可产生高达3倍的生成式AI token。这使企业能够大幅提高效率,使用相同的计算基础设施来生成更多的结果。

迄今为止,全球2800万开发者已经可以在英伟达官网下载 NVIDIA NIM,近200家技术合作伙伴正在将NIM集成到他们的平台中,以加快特定领域应用的生成式AI部署,例如 copilot、代码助手和数字人虚拟形象。

目前在英伟达官网上,提供众多热门的NVIDIA及社区模型可作为NIM端点进行体验。开发者可以从Hugging Face平台上,访问Meta最新推出的Llama 3.1模型的NVIDIA NIM推理微服务。通过基于NVIDIA GPU的Hugging Face推理端点,只需点击几下,开发者就能在其选择的云平台上访问和运行Llama 3.1 NIM。

企业还可以使用NIM来运行用于生成文本、图像和视频、语音以及数字人的应用。借助面向数字生物学的NVIDIA BioNeMo NIM微服务,研究人员可以构建新的蛋白质结构,加速药物研发。目前,数十家医疗公司正在一系列应用中部署NIM,以便在手术规划、数字助手、药物研发和临床试验优化等一系列应用中为生成式AI推理提供动力。

在前不久举行的SIGGRAPH上,英伟达也宣布全球首个用于OpenUSD开发的生成式AI模型将以NVIDIA NIM推理微服务的形式提供,这些微服务可生成回答用户查询的OpenUSD语言、生成OpenUSD Python代码、将材质应用于3D物体、理解3D空间和物理学等。OpenUSD作为一个在3D世界进行开发和协作的通用框架,再辅以NIM微服务,能够帮助开发者将生成式AI copilot和智能体整合到USD工作流中,拓宽3D世界的可能性,帮助加快USD在制造业、汽车行业和机器人等新工业领域的应用。这也意味着英伟达能够利用生成式AI为3D数据交换框架提供增强功能,加快数字孪生的开发。

值得一提的还有人形机器人领域,NIM能够帮助实现快速的原型设计和高效训练,从而为该领域带来革命性的影响。NIM提供了由NVIDIA推理软件提供支持的预构建容器,使开发者能够将部署时间从数周缩短到几分钟。这其中包括两项最新的AI微服务:MimicGen NIM微服务可根据Apple Vision Pro等空间计算设备记录的远程操作数据,生成合成运动数据;Robocasa NIM 微服务可在 OpenUSD中生成机器人任务和仿真就绪环境。这些最新的NIM推理微服务为机器人专家提供了强大的支持,帮助他们简化开发流程并加速人形机器人技术的创新。

实现闭环——发明AI,制造AI,提供AI

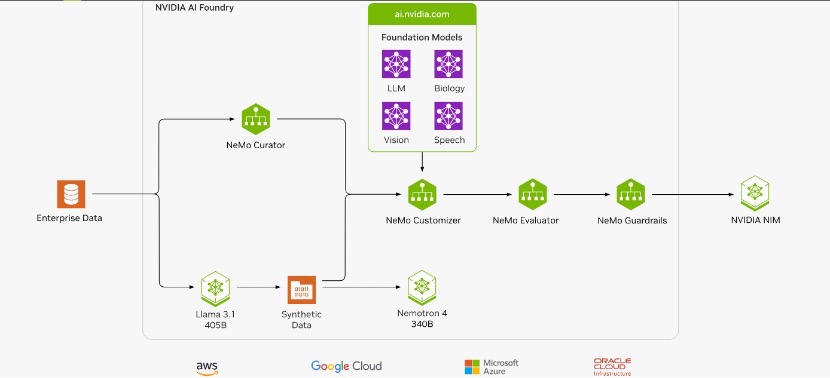

今年以来,你应该不止一次听到英伟达大力推荐最新的AI Foundry平台服务。就像台积电为半导体公司提供从设计到生产的全面解决方案,NVIDIA AI Foundry为企业提供全方位的基础设施和工具支持,包括DGX Cloud、基础模型、NVIDIA NeMo软件、NVIDIA专业知识以及各种生态系统工具和服务。可以说,AI Foundry是英伟达帮助企业解锁AI的重磅举措,使得他们在快速开发和自定义AI模型的道路上提升了一个量级。

拥有宝贵数据资产和特定领域知识的行业企业,相当于拥有两座数字“富矿”,他们往往有构建生成式AI定制模型平台和服务的需求,以最大化发挥这些数字资产的潜能。而瓶颈往往在于此——数据不能离开企业,企业本身却不具备强大的生成式AI业务开发能力。第三方服务商在提供跨平台的、端到端的定制平台或服务方面往往有所掣肘,在效率、性能、成本等方面难以权衡。虽然云托管模型API可以帮助开发者着手进行开发,但数据隐私、安全性、模型响应延迟、准确性、API成本和扩展相关的问题往往会阻碍应用投入生产环境。

NIM让这些难题迎刃而解,再从多元化的生态系统来看,英伟达作为AI Foundry赋能者,还可以提供AI模型(比如Nemotron和Edify等流行的开源基础模型),用于定制模型的软件工具,以及由英伟达AI专家构建和支持的DGX Cloud等专用计算能力。

英伟达AI Foundry可以使用企业数据以及合成生成的数据来增强和更改预训练基础模型中包含的通用知识,模型被定制、评估并设置护栏后,以NVIDIA NIM推理微服务的形式输出。NIM作为AI Foundry最终的一个输出形式,给了企业随时随地部署的自由,以及通过行业标准API进行服务调用的灵活性。

来源:英伟达官网

一方面,NIM降低了企业进入和应用生成式AI的门槛,促进了更多的创新和快速迭代。另一方面,通过AI Foundry提供的标准化和模块化AI服务,英伟达能够帮助千行百业的企业简化工作流程,加速AI应用的开发和部署。而更多的生成式AI在产业界的深度融合,将进一步颠覆AI创新,推动更大规模的生成式AI创新和落地应用。

当前,大量的数据中心正在被建造,一类是将通用计算现代化为加速计算数据中心,一类是生成式AI数据中心,而不论哪种,都蕴藏着巨大的市场机会。不过对于英伟达来说,卖GPU从来不只是卖GPU,其更大的商业愿景在于让AI的蛋糕更大,让它更易用,更便于规模化,这样一来,销售GPU也好,AI软件服务也好,都是水到渠成,形成完美商业闭环,你说是不是?

来源: 与非网,作者: 张慧娟,原文链接: https://www.eefocus.com/article/1750998.html

芯耀

芯耀

1629

1629

下载ECAD模型

下载ECAD模型