本文探讨了语义缓存在提升大型语言模型(LLM)应用程序性能中的关键作用。与传统缓存不同,语义缓存理解用户查询背后的语义,提供更快、更相关的响应。这种技术通过嵌入模型、矢量搜索等组件,显著提高了自动化客户支持、实时翻译等应用的效率,为企业优化操作和提升用户体验提供了新路径。

什么是语义缓存?

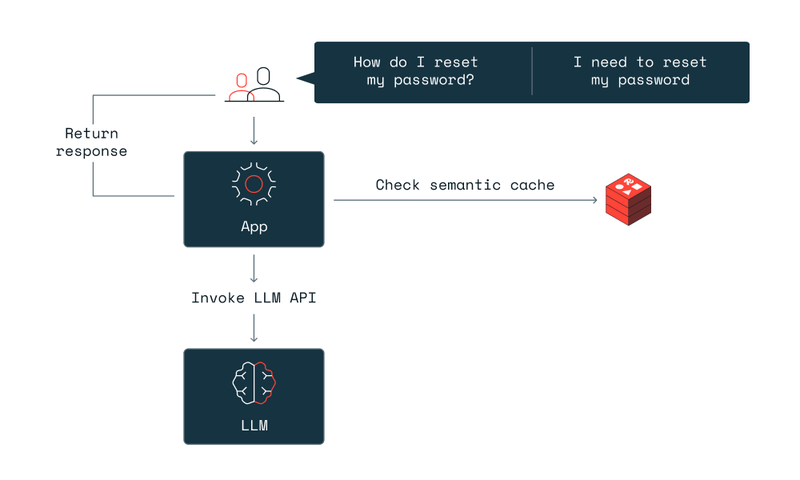

语义缓存解释并存储用户查询的语义,使系统能够根据意图而不仅仅是字面匹配来检索信息。这种方法可以实现更细致入微的数据交互,缓存所显示的响应比传统缓存更相关,也比大型语言模型(LLM)的典型响应更快。

把语义缓存想象成精明的图书管理员。他们不仅知道每本书在哪里,还了解每个请求的上下文。他们不会纯粹按照书名分发书籍,而是会考虑读者的意图、过去的阅读情况以及与查询最相关的内容。就像这位图书管理员一样,语义缓存能动态检索并提供与当前查询最相关的数据,确保每次响应都符合用户的需求。

语义缓存与传统缓存的比较

传统缓存侧重于临时存储数据,以加快频繁访问信息的加载速度,但却忽略了被查询数据的含义和上下文。这就是语义缓存的用武之地。它使用智能层来把握每次查询的意图,确保只存储和检索最相关的数据。语义缓存使用人工智能嵌入模型为数据段添加意义,使检索更快、更相关。这种方法减少了不必要的数据处理,提高了系统效率。

语义缓存系统的关键组成部分

1、嵌入模型

语义缓存系统使用嵌入。这些是数据的矢量表示,有助于评估不同查询和存储响应之间的相似性。

2、矢量数据库

该组件以结构化的方式存储嵌入数据。它有助于根据语义相似性进行快速检索,而不是使用精确匹配。

3、缓存

缓存数据的中央存储空间,其中存储了响应及其语义,以便将来使用和快速检索。

4、矢量搜索

语义缓存的一个关键过程,这一步骤包括评估传入查询与缓存中现有数据之间的相似性,以快速决定最佳响应。

这些组件通过更快、更能感知上下文的响应来提高应用程序的性能。将这些元素集成到 LLM 中,可改变模型与大型数据集的交互方式,使语义缓存成为现代人工智能系统的重要组成部分。

语义缓存的影响:快速开发 LLM 应用程序

语义缓存是LLM驱动的应用程序的可靠选择。LLM处理的查询范围广泛,需要快速、准确和上下文感知的响应。语义缓存可以有效地管理数据、减少计算需求并提供更快的响应时间,从而提高性能。

使用语义缓存检索常见问题就是一个例子。在这个聊天机器人示例中,用户询问有关国税局申报文件等内部源文件的问题,得到的答复速度是原来的 15 倍。

由于上下文感知数据是重中之重,语义缓存有助于人工智能系统提供更快、更相关的回复。这对于从自动客户服务到复杂的研究分析等各种应用程序来说都至关重要。

将语义缓存与 LLM 相结合

在使用 LLM 的应用程序中,vector search在语义缓存框架中发挥着至关重要的作用。它能让 LLM 快速筛选海量数据,通过比较用户查询和缓存响应的向量找到最相关的信息。

提高性能和效率–使用案例

语义缓存为人工智能应用程序带来了巨大的性能提升。下面是几个展示其强大功能的使用案例:

1、自动化客户支持

在客户服务中,语义缓存可快速检索常见问题的答案。现在,交互是实时的,响应是上下文感知的,从而提高了用户满意度。

2、实时语言翻译

在语言翻译应用程序中,语义缓存有助于存储常用短语及其翻译。缓存数据的重复使用可加快翻译过程并减少错误,从而提升整体用户体验。

3、内容推荐系统

在推荐引擎中,语义缓存可将用户查询与之前查询或浏览过的内容更快地匹配起来。这不仅能加快推荐过程,还能确保内容符合用户偏好。

实施语义缓存的最佳做法

(一)评估你的基础设施

有效实施语义缓存首先要选择正确的基础设施。一些关键的考虑因素包括:

1、数据存储解决方案

选择可扩展的存储解决方案,如能处理大量数据并支持快速数据检索的 Redis。这些系统善于管理语义缓存所需的复杂数据结构。

2、缓存策略

根据应用程序的需求,在内存缓存和持久缓存之间做出选择。内存缓存的访问速度更快,但成本较高,而且数据量有限。持久缓存虽然速度较慢,但可以处理较大的数据集,并确保数据的持久性。

(二)设计可扩展性和性能

为确保语义缓存系统能够处理不断增加的负载并保持高性能,请考虑以下策略:

1、负载平衡

实施负载平衡,在整个系统中有效地分配查询,防止系统的任何单一部分成为瓶颈。

2、优化数据检索

使用高效的数据检索算法,最大限度地减少延迟。这包括优化矢量和缓存存储中的数据索引和查询方式。

(三)确保准确性和一致性

保持响应的准确性和一致性至关重要,尤其是在数据和用户交互不断变化的动态环境中。

1、相似性阈值

小心管理相似性阈值,在响应的准确性和缓存响应的广度之间取得平衡。过于严格的阈值可能会限制缓存的实用性,而过于宽松的阈值则可能会降低响应的相关性。

2、一致性策略

实施策略,确保缓存数据与源数据保持一致。这可能涉及定期更新和检查,以使缓存响应与当前数据和查询趋势保持一致。

(四)实施语义缓存

要将这些做法整合到一个连贯的实施策略中,可以遵循以下步骤:

第 1 步:评估当前系统的功能,并确定对可扩展性、响应时间和成本改进的需求。

第 2 步:根据系统需求和预算选择合适的缓存和存储技术。

第 3 步:配置语义缓存层,重点关注 LLM 封装器、矢量数据库 和相似性搜索等关键组件。

第 4 步:持续监控和调整相似性阈值和缓存策略,以适应新数据和不断变化的用户行为模式。

通过遵循这些最佳实践,企业可以充分发挥语义缓存的潜力,从而提高性能、改善用户体验并提高运营效率。

应用程序的新时代

语义缓存代表着一个巨大的飞跃,它能提升 LLM 的性能,使人工智能应用程序全面提速。通过智能管理数据的存储、访问和重用方式,语义缓存降低了计算需求,实现了实时响应时间,并确保了输出的准确性和上下文感知能力。在数据密集的环境中,快速和相关的响应就是一切。

展望未来,语义缓存的作用将变得更加重要。查询变得越来越复杂,对实时数据处理的需求也越来越大,这就需要更复杂的缓存策略。GenAI 处理和后处理变得越来越复杂和耗时,需要加快响应的策略。随着模型变得越来越强大,使用最佳模型的计算成本越来越高,企业只会继续优化其支出。语义缓存可以迎头应对这些挑战,使数据检索更快、更智能。

使用更智能的工具、获得更快的结果。

要想最大限度地利用语义缓存,你需要功能强大、用途广泛的工具。Redis是世界上速度最快的数据平台,它能将你的语义缓存策略带入实时状态。凭借高性能数据处理和对多样化数据结构的支持,Redis 可优化响应速度和效率,使您的 GenAI 应用程序更加快速。

了解Redis更多信息,欢迎前往【艾体宝】官方网站

联系技术工程师:TEL:15627590301

芯耀

芯耀

728

728

下载ECAD模型

下载ECAD模型