相比于英伟达,国产AI芯片除性能差距外,软件生态差距更大,英伟达的成功不仅仅在于其芯片,更在于其软件栈CUDA的成功,英伟达已累计为CUDA生态投入120亿美元。

同时,自2020年以来,CUDA开发者数量从180万激增至450万,增长了150%。

面对国外AI算力软件生态壁垒高筑的现实,中国的AI算力还有机会吗?或者说,在AI领域,RISC-V是否有机会去震撼CUDA生态呢?

对此,北京大学讲席教授、RISC-V国际基金会人工智能与机器学习专委会主席谢涛分享了专业角度的观察和分析。

图 | 北京大学讲席教授、RISC-V国际基金会人工智能与机器学习专委会主席谢涛

“国产算力面临巨大挑战,虽然国产AI芯片公司都在加速追赶,也在芯片性能上获得了很大的进步,但我们要清醒地认识到,我们的竞争对手太强,面对CUDA的庞大生态大军,我们要如何应对?” 谢涛抛出问题。

国产AI芯片公司,也包括国际上部分AI芯片公司在内,大家通常会采取“打不过就加入”的思路,也就是采用兼容CUDA软件生态、特别是走GPGPU路线的做法。

对此,谢涛认为:“这样的一个道路只能解燃眉之急,但是长远来看它还是受制于人;而其它的一些AI芯片公司走的是非CUDA路线,整体上呈现出的是‘小、散、弱’的局面。”

这种局面具体来讲,可以总结为四点:

2.软件栈不统一,用户学习成本高;

3.算子覆盖度低,用户迁移成本高;

4.企业各自为战,没有足够的生态竞争力。

所以,我们可否借鉴Android震撼iOS生态的模式,来让“RISC-V+AI”去震撼CUDA生态呢?

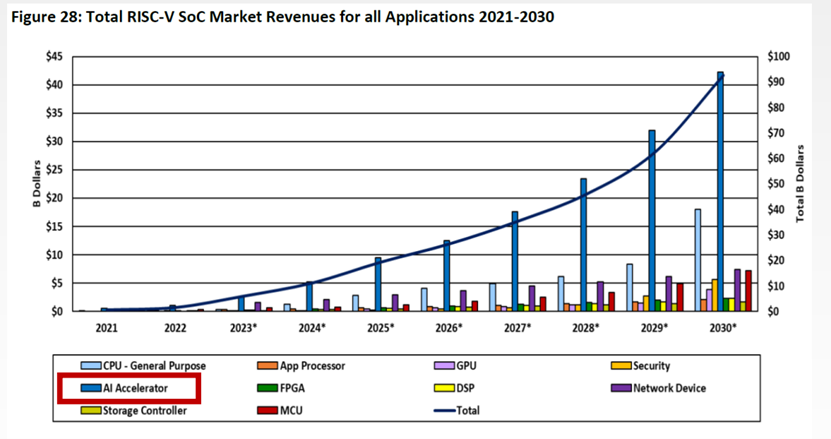

图 | AI加速器市场规模增速最快,来源:芯原,The SHD Group

我们来看一组数据,根据SHD Group的最新调研结果显示,2023年RISC-V SoC的市场渗透率将达到2.6%,市场规模触及61亿美元,其中AI加速市场的规模为26亿美元,成为RISC-V SoC市场的“王牌选手”,占比42.6%;此外SHD Group更是预测,到2030年,该占比将继续上升至49.2%。

换言之,RISC-V 是发展AI专用处理器共识之路,可以通过其可扩展性和定制化,满足AI工作负载快速变化的需求。

面对该趋势,谢涛对主流的模式进行了总结:紧耦合模式和松耦合模式。

其中,紧耦合模式适用于低功耗领域,在这种模式下,RISC-V架构将AI计算单元集成在CPU内部,实现资源共享;而松耦合模式则适用于大算力领域,通过外挂协处理器的方式来执行AI任务,提供更强大的计算能力。

谢涛认为,在未来的发展中,RISC-V+AI的生态系统将通过推动国际标准和共建开源社区的双重手段,逐步壮大并与现有的AI计算生态形成有力的竞争。在这一过程中,中国将发挥关键作用,通过共建、共创,推动RISC-V在全球AI计算领域的广泛应用,助力全球科技的可持续发展。

图 | 万物智联时代的RISC-V+AI算力之路,来源:芯原

而回到最初提出的问题,在AI领域,RISC-V能否震撼CUDA生态呢?谢涛表示:“RACE也将团结企业一起探索、探讨,也要定出Triton,比CUDA要更高层的生态,而从心态上,我们应该保持谨慎乐观的态度。”

芯耀

芯耀

3443

3443

下载ECAD模型

下载ECAD模型

[课程]STM32电机控制软件开发软件X-CUBE-MCSDK 6x介绍

[课程]STM32电机控制软件开发软件X-CUBE-MCSDK 6x介绍