由于AI需求大幅升温,最近两季AI服务器相关客户向供应商进一步要求加单Enterprise SSD(企业级固态硬盘)。上游供应商为了满足SSD在AI应用上的供给,加速制程升级,开始规划推出2YY产品,预期于2025年量产。

TrendForce集邦咨询表示,AI服务器客户对供应商加单的情况,导致Enterprise SSD合约价于2023年第四季至2024年第三季间的累积涨幅超过80%。SSD在AI发展中扮演重要角色,除了在AI模型训练过程中,SSD不仅负责储存模型参数,包含不断更新的权重和偏差,另一项重要应用是创建检查点(check point),以定期保存AI模型训练进度,即使训练中断也能从特定点恢复。上述功能都相当依赖高速传输以及写入耐用度,因此客户主要选择使用4TB/8TB TLC(三层单元闪存) SSD产品,以满足严苛的训练过程需求。

TrendForce集邦咨询指出,SSD应用于AI推理服务器,可在推理过程中协助调整、优化AI模型,尤其SSD可以实时更新数据,以便微调推理模型结果。AI推理主要提供检索增强生成(RAG, Retrieval-Augmented Generation)和大型语言模型(LLM, Large Language Model)服务,而SSD可以储存RAG和LLM参考的相关文档和知识库,以生成含有更丰富信息的响应。此外,随着更多生成信息是以影片或相片显示,其数据存储量也相应增加,因此,TLC/QLC(四层单元闪存) 16TB以上等大容量SSD便成为AI推理主要采用的产品。

AI SSD需求位元年增率超过60%,供应商加快大容量产品开发

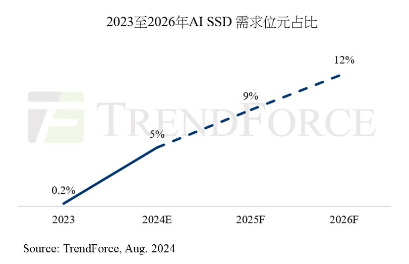

2024年AI 服务器SSD市场除了16TB以上产品需求自第二季大幅上升,随着NVIDIA H100、H20和H200等系列产品到货,相关客户进一步加大TLC 4、8TB Enterprise SSD订单需求。根据TrendForce集邦咨询预估,今年AI相关SSD采购容量将超过45EB,未来几年,AI服务器有望推动SSD需求年增率平均超过60%,而AI SSD需求在整个NAND Flash(闪存)的占比有机会自2024年的5%,上升至2025年的9%。

在供给市场方面,由于推理服务器采用大容量SSD产品的趋势不变,供应商已开始加速升级制程,计划从2025年第一季起,量产2YY/3XX层制程的产品,并推出120TB 的Enterprise SSD产品。

726

726

下载ECAD模型

下载ECAD模型