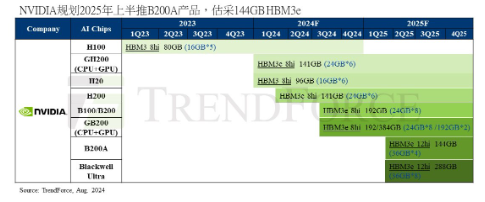

市场近日传出NVIDIA(英伟达)取消B100并转为B200A,但根据TrendForce集邦咨询了解,NVIDIA仍计划在2024年下半年推出B100及B200,供应CSPs(云端服务业者)客户,并另外规划降规版B200A给其他企业型客户,瞄准边缘AI(人工智能)应用。

TrendForce集邦咨询表示,受CoWoS-L封装产能吃紧影响,NVIDIA会将B100及B200产能提供给需求较大的CSPs客户,并规划于2024年第三季后陆续供货。在CoWoS-L良率和量产尚待整备的情况下,NVIDIA同步规划降规版B200A给其他企业客户,并转为采用CoWoS-S封装技术。

TrendForce集邦咨询预期,B200A的热设计功耗(TDP)将比B200低,搭配该芯片的GB Rack(机柜)可采用气冷散热方案,预计2025年较不受设计难度高且复杂的液冷散热影响,从而避免出货延迟等问题。B200A的存储器规格将采用4颗HBM3e(第五代高带宽内存) 12hi(12层堆叠),总容量为144GB。预期OEMs(原始设备制造商)应会于2025年上半年后正式拿到B200A芯片,这个供货时间点能让延迟至今年第三季才能放量的H200有更多被市场采用的机会,避免产品线相隔太近而产生冲突。

Blackwell将占2025年NVIDIA高端GPU出货量逾8成

根据TrendForce集邦咨询对供应链的调查,2024年NVIDIA的高端GPU(图形处理器)出货将以Hopper平台产品为主,除针对北美CSPs、OEMs出货H100、H200等机种,针对中国客户则以搭载H20 的AI 服务器为主力。预估H200在2024年第三季才能开始放量、成为NVIDIA主流机种,并延续至2025年。

TrendForce集邦咨询指出,Blackwell系列于2024年仍在前期出货阶段,进入2025年,Blackwell将成为出货主力,以效能较高的B200及GB200 Rack满足CSPs、OEMs对高端AI服务器的需求。而B100属过渡型、主打耗能较低的产品,在NVIDIA出货完既有CSPs订单后,B100将逐渐被B200、B200A及GB200 Rack取代。TrendForce集邦咨询预估,2025年Blackwell平台将占NVIDIA高端GPU逾8成,并促使NVIDIA高端GPU系列的出货年增率上升至55%。

1988

1988

下载ECAD模型

下载ECAD模型

[生态]STM32 合作伙伴计划:打造生态强纽带

[生态]STM32 合作伙伴计划:打造生态强纽带