生成式AI因ChatGPT的风靡不断刷新热度,随之而来的是进一步的探索和落地尝试。一个趋势是,云端的机遇正传导至边缘和端侧,给这些市场埋下一颗大彩蛋。

混合AI的机遇

高通高级副总裁Alex Katouzian最近表示,高通正在从通信公司转型为“智能边缘计算”公司。他指出,“随着连接设备和数据流量加速增长,叠加数据中心成本攀升,(我们)不可能将所有内容都发送到云端。”

高通看到的机遇,其实也反映了AI当下的两大趋势:

首先,不止云端,边缘AI成为必然趋势,边缘计算具有低时延、降低带宽依赖、降低成本、数据可控、高可靠性等核心优势,可与云端计算互补协同,是解决推理加速最后一公里的关键所在。

其次,“连接+计算”的能力越来越关键。

在云端市场,英伟达正在实现从计算到连接能力的突破,随着模型参数的急剧膨胀、GPU要处理和传输的数据量飙升,英伟达通过升级NVLink系统、赋予以太网AI能力,使网络连接技术攀上了新台阶。

在边缘市场,高通正在做类似的事情,不过与英伟达相反,它是从通信连接能力向算力进发。与英伟达在云端的计算能力相对应,高通在无线通信基带、手机计算芯片市场,都占据领先地位。随着“算力”成为AI时代的宝贵资源,高通已经不满足于通信市场,而是希望集连接+计算能力于一身,从边缘侧进攻AI大市场。

那么,高通在边缘AI市场主打什么战略?目前看来,主要是云边一体的混合AI路径。从高通已有的模型落地案例来看,其边缘大模型相当于云端大模型的“感知器官”,从而实现AI功能在终端设备的实现。

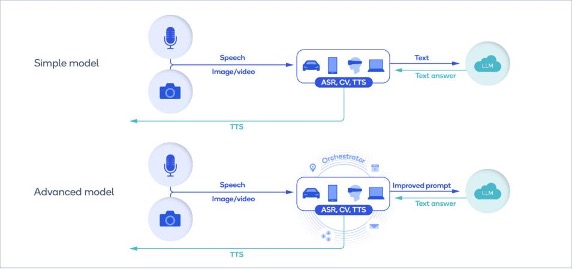

今年2月,高通就利用AI 软件栈执行了全栈的AI优化,首次在Android智能手机上部署了Stable Diffusion。在这个场景中,用户对着手机说话,自动语音识别AI模型(如Whisper)可以在手机设备上将语音转换为文本,然后发送到云端,再由云端运行大模型,回发文本答案。

来源:高通混合AI白皮书

根据高通最近发布的混合AI 白皮书,上述场景就是一个典型的混合AI场景。并且在未来的进阶版本中,设备端AI可以承担更多处理,通过与调度程序协作,可以基于上下文提供更个性化的提示给云端,例如:用户要求手机预约和朋友在最爱的餐厅吃饭,对简单查询、较小的模型可在设备上运行而无需云交互;如果用户需要复杂信息,则本地将需求转化为提示发给云端大模型并返回详细答案。

高通认为,混合AI主要有以下优点:

第一,经济性:降低云端推理成本、高效利用边缘算力、降低 AI 应用开发门槛;

第二,能耗低:边缘设备可以通过较低能耗运行大模型,若考虑处理和数据传输等因素,能耗节约更加显著;

第三,可靠性:边缘 AI 不受网络状况影响,运行更加稳定;

第四,隐私性:数据完全在本地推理,大幅降低泄密风险;

第五,个性化:边缘设备可以通过用户真实生活中的行为、价值观、痛点、需求、关注问题等信息,形成个人画像,提供更为个性化服务。

预计2023年,边缘AI将覆盖10 亿参数以下的各类模型。

为什么要在边、端部署生成式AI?

目前,端、边的市场需求已经足够丰富,小到录音笔、手机,大到ADAS辅助驾驶、自动驾驶……各类应用都在响应AI趋势进行升级。那么,生成式AI的落地,现实吗?有必要吗?在与一些业内人士的交流中,他们已经看到了足够的理由和空间。

比如将Transformer大模型应用在视觉领域,它将具有一定的画面语意理解能力,有希望解决以往的一些痛点。AI数据和模型的部署流程通常是:采集数据—标注—训练,那么,一旦出现没见过的场景,或是某场景下的数据没有标注过,就会导致应用效果大打折扣或无法落地。

以河道垃圾监测的视觉应用为例:当河道上出现了一种新垃圾,是之前数据标注/训练没有的。如果是以往的AI系统就会无法识别,必须重新采集。但有了采用无监督训练的大模型之后,无论出现什么样新类型的垃圾,系统都能自主推理和判断,大大提高了效率和应用效果。

基于类似上述提升做出判断,爱芯元智联合创始人、副总裁刘建伟认为,一直以来,AI落地标准化场景效果较好,而在一些通用场景,除非增加针对性的投入,才能进一步提升应用效果,但这同时意味着更高的成本,成为AI加速应用落地的主要困难。

从大模型带来的改变来看,它能够降低边际场景的AI成本,因为它不需要对长尾场景做专门的、从头到尾的适配,通过部署预训练的大模型就能达到比较好的效果,这将使AI在端侧和边缘侧的应用再上一个台阶。

安谋科技产品总监杨磊认为,ChatGPT等应用催生了对算力需求指数级的提升,而云端的需求早晚会传导到端侧,届时,端侧原有的CPU能力是不足以负担的。此外,应用的需求也会越来越丰富,包括成本、性能、功能特性等核心指标。“很难通过一种方案或一种架构去满足所有,还是需要各类处理器的创新联动,以更高的异构水平来满足市场的诉求”,杨磊指出了异构加速平台的发展机遇。

近些年来,AI已经广泛应用于物联网的各个垂直领域,包括零售、安全、能源和公共事业、供应链和资产管理等。而通过生成式AI的发展,各类AIoT应用在酝酿新一轮创新。

未来,智能终端接入大模型的方式将主要有:直接调用、大模型小型化后再调用、以及接入行业专属大模型等。这些方式都将带动边缘和端侧计算的成长,带来使用体验的提升,或将加速相关设备的更新迭代。以手机为例,当前正面临消费者换机动力不足、总销量下滑明显的局面,而AI大语言模型的小型化、轻量化,可望在终端应用中内嵌部署,带来终端推理计算能力的提升,从而推动智能终端再升级。

低功耗设备积极拥抱大模型

如何在低功耗环境下,让AI更高效地运行——这是业界近几年一直在探索的方向。不过,生成式AI展现的巨大潜力,正在加剧端侧AI市场的步伐,特别是已有成熟生态的动向值得关注。

几周前,Google I/O大会重点强调将把生成式AI引入安卓生态系统,微软Build开发者大会也在谈论将其引入Windows 11操作系统。

Arm最近发布 2023全面计算解决方案(TCS23)时,Arm高级副总裁兼终端事业部总经理Chris Bergey谈到,未来将是一个“混合(Hybrid)的环境”, 即大型语言模型在云端运行,但考虑到智能手机或其他计算设备在本地运行AI的隐私和能源效率等问题,用户更愿意在设备上运行较小的模型。这意味着,大语言模型将塑造计算的未来,现有计算平台需要进一步提升AI方面的工作负载适配。Chris Bergey认为,生成式AI将给未来的智能手机生态系统带来深远影响。

这一趋势已在Arm TCS23中有所体现,主要包括:为满足高性能、高能效、多线程用例的CPU集群设计,针对大数据流量的三级缓存和电源设计等等,这些重大升级也将助推生成式AI在端侧的部署。

不止高通、谷歌、Arm对云端之外的市场表示重视,英特尔最近也分享了生成式AI方面的动向和观点。与之前“让AI无所不在”的方向一致,英特尔也强调了“让生成式AI无所不在”的观点。

在搭载第12代酷睿处理器的笔记本电脑上,英特尔展示了运行Stable Diffusion的效果,不需要任何独立显卡,直接利用集成显卡就可以在二、三十秒内生成一张图片。也就是说,不需要任何特殊设备,不需要访问云端,就可以将任意模型和算法直接部署到本地笔记本上。当然,如果用户有Arc独立显卡,那么速度可以更快,只要三、四秒就可以生成一张图片。

这个场景的独特之处,一方面在于基于异构计算来跑生成式AI,另一方面展示了低功耗PC设备跑Stable Diffusion大模型、实现文生图等生成式AI的潜力。

在生成式AI的普及方面,英特尔强调了端到端的计算能力。英特尔院士、大数据技术全球首席技术官戴金权认为,“为了实现AI无所不在,计算也要无所不在。在通用的、无所不在的、甚至是消费级的计算上提供AI能力,就真的可以做到AI、包括生成式AI的无所不在。”

生成式AI对软硬件架构的影响?

边缘AI已经成为业界共识,而生成式AI正在给边缘带来更大机会,业界对边缘的理解也将进一步拓展。

不同于由超大型数据中心、智算中心等形式部署的云端算力,边缘算力的部署方式随着智能设备、边缘数据中心的出现变得多样化。边缘计算可以是离模型推理发生处最近的算力,也可以是帮助云端算力进行预推理的算力。

生成式AI对边缘、端侧软硬件架构有哪些影响?戴金权认为,未来,一个很可能的场景就是生成式AI被大量使用、提高工作效率,未来的工作流程进入自动化,这对软硬件架构都带来影响。

大模型当前基本以Transformer架构作为基础构件,它对内存的需求,包括内存带宽、内存容量以及相应的计算需求,业界还在进行大量的研究,以便更好地进行加速。此外,对训练、推理芯片的架构设计,以及对不同算法级别、不同场景的适配等等,都会对AI芯片甚至所有计算芯片带来深远影响。

未来,Transformer等大模型可能会产生更大的尺寸,可能是今天的几倍、几十倍甚至更高,再结合多模态融合等需求,将会对软件算法的设计,比如低精度、低比特、压缩、稀疏化,包括注意力机制设计等产生不同需求。未来,软件算法设计的多样化,是有助于满足生成式AI和大语言模型算力需求的重要组成部分。

写在最后

从发展的眼光看,生成式AI仍处于非常早期的阶段,在边缘、端侧的研究和落地探索也在初期。

除了边缘、端侧市场的主动拥抱,一些趋势也在推动云边端一体的生成式AI布局。

比如,AI 模型推理Token 费用较高,如果需要成熟商用,边缘预处理将是必选项。用户的多样化需求进行本地预处理后,简单需求就可以直接利用本地模型和算力推理,复杂需求通过边缘算力预处理后,可以精简成最少的Token发送至云端,从而能够以最低成本实现应用功能,加速商业化。

再比如,文中提到的安卓、Windows、Arm等已有成熟生态的积极部署,也将加速生成式AI向边缘和端侧市场的渗透速度。未来,它们都将成为生成式AI体系中的重要部分,成为AI连接万物的毛细血管。

1862

1862

下载ECAD模型

下载ECAD模型

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

-1.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

-2.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

[生态]STM32 合作伙伴计划:打造生态强纽带

[生态]STM32 合作伙伴计划:打造生态强纽带