最近两周,全球人民都想和一个叫ChatGPT的聊天,搞得服务器两天宕机了五次......

这个在去年11月底,由人工智能实验室OpenAI推出的AI程序,上线5天内收获超100万的注册量,到今年1月末已经突破1亿!要知道,TikTok达成1亿小目标花了9个月,Twitter可是用了60个月!这“涨粉”速度不去带货真是可惜了......

能瞬间在全球范围内成为“当红炸子鸡”,并且让中国AI概念股股民狂喜的ChatGPT到底是何方神圣?它的爆火说明了什么?它的背后又和芯片有哪些关系?

阅读本文,你将了解以下内容:

1. ChatGPT是什么?

2. ChatGPT背后的芯片

ChatGPT到底是个什么鬼?

官方点说,ChatGPT是由OpenAI开发的一个人工智能聊天机器人程序。将它的名字拆开来,“Chat”指聊天,就是它的展现形式;“GPT”则代表Generative Pre-trained Transformer(生成型预训练变换模型),即支撑它运行的预训练模型。ChatGPT使用了Transformer架构并训练了大量的文本数据,能够进行语言翻译、问答、对话等任务。

从体验上来说,它像是有想法、会学习的高阶版“小爱同学”,能通过不断的对话记住你提供的信息,来不断丰富自己的语料库并提供答案。

没错,在你对面的,是一个真正的工具“人”。

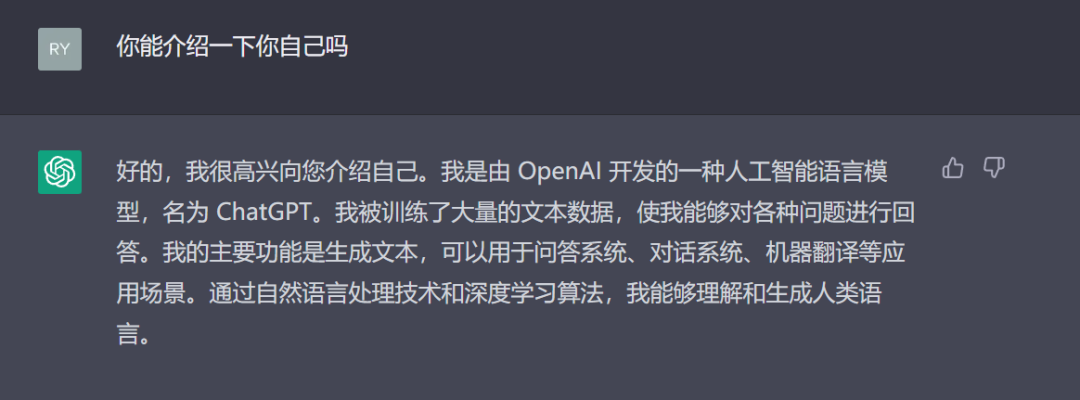

ChatGPT眼中的自己

AI出现了那么久?为什么这个这么火爆?

GPT的核心结构是Transformer。想要完整了解ChatGPT,得先从它说起。

Transformer是是一种采用自注意力机制的深度学习模型。简而言之,神经网络是一种非常有效的模型类型,用于分析图像、视频、音频和文本等复杂数据类型。

在它之前,我们使用深度学习来处理输入序列的方式是使用一种叫做循环神经网络的RNN的模型。它要求输入的数据必须顺序正确,因为它只能按顺序一对一的输出,所以RNN很难达到并行化,这意味着我们不能通过使用更多的GPU来加快训练。

来源:知乎用户@张俊林

Transformer则能够一次性处理所有输入数据,不再要求顺序准确,可以非常有效地进行并行化操作。也就是说,如果有合适的硬件条件,我们可以训练一些真正的大模型。

来源:知乎用户@张俊林

GPT便是以此架构为基础诞生的。

第一代的GPT-1在2018年发布,首次采用了 Transformer 架构作为特征抽取器,解决了传统 RNN 结构的缺陷与效率问题。然而,当时的数据量只有1亿多,和现在动辄千亿比起来少得可怜,因此它的表现并不好,只在问题回答、语义相似度评估、语义确定、文本分类任务中简单应用。毕竟数据量越大,机器学习得以学习的基础越多,效果更精准、更智能的可能性就越高。

GPT-2在下一年发布,底层架构没变,参数量有了大幅的提升。到了GPT-3,模型参数达到了1750亿个,它已经可以完成答题、写论文、文本摘要、语言翻译和生成计算机代码等真正意义的 AI 创作。

为什么前面几版都悄无声息,到了ChatGPT突然大爆了呢?

简单来说,就是能力发生了质变,一下子变得好“牛”。

ChatGPT是在GPT-3衍生而出的GPT3.5上进行微调而诞生。

ChatGPT 采用了 RHLF (Reinforcement Learning from Human Feedback,基于人类反馈的强化学习)算法,采用人工标注的方式将NLP(Natural Language Processing,自然语言处理)和RL(Reinforced Learning 强化学习)结合起来,极大地提升了模型效率和学习能力。

此前的GPT-2和GPT-3为了大幅增加参数量,都采用无监督学习模式,也就是输入一堆数据,让模型自己去学,不进行人工干涉。而到了ChatGPT,为了让他更好用,引入了人工标注数据和强化学习,可以让大模型更理解信息的含义,并进行自我判断——也就是更贴近理想中的人工智能效果。也就是说,以前对的错的一起全吸收了,现在则有人告诉它对错,让他更懂。

就像我们在使用ChatGPT的时候,前面问得越多、给出的信息越多,它提供的回答便会更符合我们的要求。

只要铺垫够多,2+5也可以是8

ChatGPT 代表着 AI 技术的新一轮突破,并且大概率预示着 NLP 技术有望迅速进入平民化应用时代,相关技术不仅对众多的 C 端应用带来革新,同时也将对 B 端应用产生重大影响。

微软在2月7日宣布将ChatGPT引入旗下的搜索引擎必应和Edge浏览器。这一下子让整个互联网圈炸开了锅,一些龙头企业火速跟上:谷歌宣布推出AI对话机器人“Bard”(吟游诗人);百度宣布类似ChatGPT的项目“文心一言”3月面世......

短时间内重磅消息频出,ChatGPT终于破圈,遍地开花。

ChatGPT背后的芯片

一般内容创作分为三个阶段:专业生产内容(PGC)、用户生产内容(UGC)、AI生产内容(AI Generated Content,AIGC)。早期专业视频门户网站采用PGC模式,而现在一些主流的社交平台如抖音、小红书、微博等是以UGC为核心的传播方式。

目前以PGC、UGC为主,AIGC为辅,AIGC被认为是继PGC和UGC后,新的内容创作方式。

ChatGPT只是AIGC中的一环,如AI写作、AI作曲以及此前爆火的AI绘画等都属于AIGC中的一种。随着AI技术的成熟,过去的“人工智障”已经蜕变成“数字人”,在娱乐、金融、零售业等发挥着作用:早在2016年的里约奥运会上,写稿机器人就参与了赛事报道。光百度推出的数字人系列就包括AI手语主播、虚拟偶像、虚拟编辑等,其AI技术已经用于央视,并参与了去年两会的报道。

ChatGPT是一种基于大规模语言模型的超智能对话AI产品,无论是探讨概念化的AIGC,还是爆火的ChatGPT,本质上是在探讨其背后的AI产业链。

人工智能三大要素:数据、算法、算力,这三大要素相辅相成,缺一不可。

如前文所述,ChatGPT是基于OpenAI的第三代大模型GPT-3升级而来,从GPT一代到三代,模型参数量已经来到1750亿个,理论上参数量会随着算力的增长而增长,极限在哪尚未知。

而算力的来源就是芯片。ChatGPT的爆红,势必会推动AI芯片产业的发展。

来源:ChatGPT——生成式AI迎来拐点,商用落地前景可期,国泰君安证券

AIGC产业链可以分为计算硬件层、云计算平台、模型层及应用层。虽然ChatGPT比拼的是模型层和应用层,但计算硬件层无疑是背后的支柱。

AI算力芯片泛指加速AI类应用用,主要分为GPU、FPGA、ASIC。由于CPU的算力很有限,且处理并行操作比较吃力,因此一般将CPU搭配加速芯片使用。具体来看,GPU最初是用于图像处理的芯片,但其通用性强,适用于大规模并行计算,且算力远优于CPU,因此很适合人工智能,这一数据密集型的应用场景;FPGA的优势在于开发周期短、灵活性高,大量应用在线上数据中心、军工领域等;ASIC的优势在于小型化、低功耗、高性能,一般用于消费电子,同时也适合AI运算场景。

ChatGPT背后的计算集群使用的是英伟达的AI芯片。OpenAI曾表示,ChatGPT 是与英伟达和微软合作完成的超级AI。微软在自己的云——Azue HPC Cloud中构建了超级计算机集群,将其提供给OpenAI。据悉,该超级计算机拥有 285000个CPU(中央处理器)内核和10000多颗AI芯片。

除了算力芯片外,AI对话程序在执行计算期间需要大容量、高速的存储支持,预计高性能存储芯片需求也会增长。三星电子就表示,为GPU和人工智能加速器提供数据的高性能高带宽内存 (HBM) 的需求将会扩大。从长远来看,随着AI聊天机器人服务的扩展,对用于CPU的128GB 或更大容量的高性能 HBM 和高容量服务器 DRAM 的需求预计会增加。

降本、降功耗成为发展AI专用芯片的方向。据了解,采购一片英伟达顶级GPU成本为8万元,GPU服务器成本通常超过40万元。对于ChatGPT而言,一次模型训练成本超过1200万美元。正如OpenAI CEO SamAltman曾在推文中所说的那样:“用户每次与ChatGPT进行聊天,会花费几美分。”

随着SoC技术的发展,越来越多的企业开始推出自研的AI专用芯片,如谷歌的张量处理器TPU、英伟达的数据处理器(DPU)BlueField系列、百度的昆仑系列、华为的昇腾系列、阿里巴巴平头哥的含光800等。亿欧智库的数据显示,随着大算力中心的增加以及终端应用的逐步落地,中国AI芯片需求也持续上涨。2021年疫情缓解,市场回暖,产生较大增幅;类脑等新型芯片预计最早于2023年进入量产,因此2024及2025年或有较大增长,预计市场规模将于2025年达到1740亿元。

从AI芯片的计算功能来看,由于AI应用模型首先要在云端经过训练、调优与测试,计算的数据量与执行的任务量数以万计,云端训练需求是AI芯片市场的主流需求。而到后期,训练好的AI应用模型转移到端侧,结合实时数据进行推理运算、释放AI功能,推理需求逐渐取代训练需求,带动推理芯片市场崛起。2025年,云端推理与端侧推理成为市场规模增长的主要拉动力,提升了逐渐下滑的AI芯片市场规模同比增速。

中国AI芯片市场入局者众多,海思半导体已成为国内营收规模最大的集成电路设计企业,以昇腾系列为主要GPU产品,在AI终端芯片具有优势。云端领域,百度可提供云上GPU服务器;海光信息、天数智心与登临科技均以GPU为主打,是国内特定细分领域的主要竞争对手。

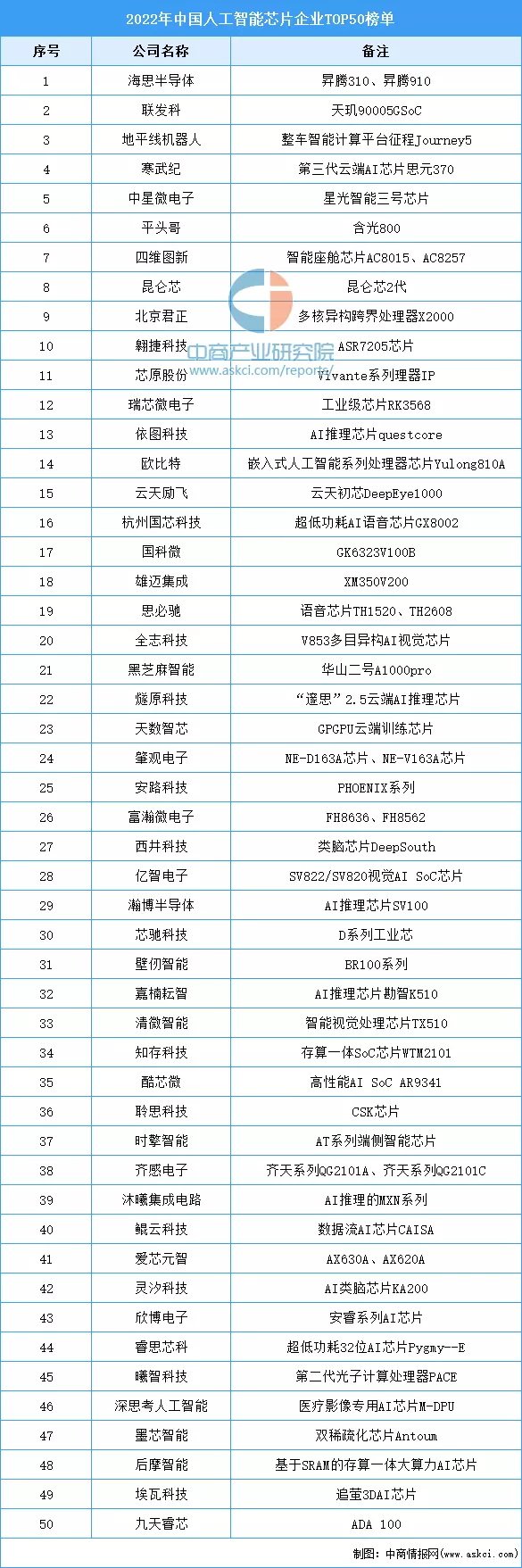

以下是2022年中国人工智能芯片企业TOP50:

结语

早几年,AI创业的热潮、资本的疯狂涌入还历历在目,那时凭空出现的“AI专家”,被抢上天的“AI程序员”,终于在潮水退去后,沉寂下来。ChatGPT的成功破圈,似乎又看到了当初那股子“激情”再现。但ChatGPT还需要多久能落地?落地到底能给人们带来些什么?落地过程中要花费多少成本?这个成本是否能够承担得起?

小冰CEO李笛在谈到成本问题时表示,如果用ChatGPT的方法,小冰每天成本将高达3亿元,一年成本超千亿元。

且不说这没日没夜的电费账单,就高昂的芯片价格和运营成本或许都能劝退不少“雄心壮志”的企业。所以,ChatGPT能发展到哪一步?又能带动高端芯片产业几分?一切难以下定论。

1837

1837

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

.jpg?x-oss-process=image/resize,m_fill,w_128,h_96)

[下载]LAT1482 STM32G0单线串口通信帧错误问题解析

[下载]LAT1482 STM32G0单线串口通信帧错误问题解析