增强现实可穿戴设备如谷歌眼镜,已经成为人们十分关注的未来人机交互体验工具,相比手机,它拥有更加直观的数据呈现方式,也能够提供更主动式的服务,因为它就戴在你的脸上。 当然,目前谷歌眼镜的发展似乎遇到了一些瓶颈,在此前的文章中我们也讨论过,主要是由于外形设计不佳、隐私窥探、正式版遥遥无期等问题,让人们对谷歌眼镜的热情有所下降。另外,还有谷歌眼镜采用的语音交互方式,也带来了一定的局限性。试想一下,在一个嘈杂的酒吧说“OK,Glass”,不仅眼镜无法识别,也会让周围人反感。 那么,有没有一种可能性让谷歌眼镜可以实现类似“Kinect”体感摄像头的操作呢?一家位于美国波特兰的软件厂商给出了答案:ARI应用。近日,该公司发布了首个测试版本,让我们看到了一种新的人机交互模式。

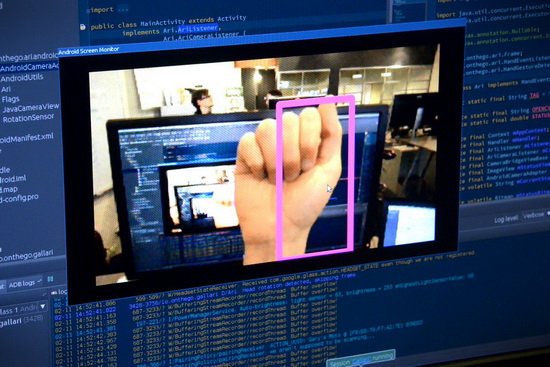

ARI的创始人Ryan Fink表示,当移动计算机应用从手机转移到你的眼睛,一个新的操作形式势在必行,“ARI”就提供了这样的一种体验。你可以把它看作是手势识别版的“siri”,但不需要任何按钮,直接就能够使用。 那么,怎么使用ARI呢?非常简单,佩戴谷歌眼镜时,将手握拳举到眼前,ARI便会开始识别,3秒钟后,你就可以使用各种手势来实现操作了,比如滑动、翻页等等。最终,ARI会开放API接口,也就是说每一款谷歌眼镜应用,理论上都能够通过手势来操作。 操作谷歌眼镜的新方式

ARI的创始人表示,开发这个软件平台的初衷在于他们发现谷歌眼镜的操作形式不够灵活,语音技术会遭到环境的限制,最终让智能眼镜产品成为一种“花瓶”式的产品。ARI的出现,则意味着智能眼镜可以应用在更多场景中,比如戴着厚厚手套无法触摸眼镜按键的滑雪运动员。 ARI在游戏环境下也具有更大的发展前景,毕竟没有一个用户想通过大叫“飞起来,小鸟”来操作Flappy Bird;但是微软Kinect已经证明,玩家逐渐接受了“手舞足蹈”式的体感操作。 前景光明但需要解决一些问题 在使用中我们发现了一些ARI的问题,比如测试识别手势花费时间较长,需要明确地手势动作才能够准确识别等,不过目前ARI尚处测试阶段,这些问题都有待日后逐步完善。另外,ARI实际上是直接运行在谷歌眼镜中的应用,而非手机,所以谷歌眼镜较慢的处理器可能也对操作产生了一定的影响。 谷歌眼镜的摄像头也是一个问题。新的微软Kinect或是索尼PS4摄像头都内置了双镜头,用来实现景深判断,但谷歌眼镜的单摄像头显然无法实现这种效果,这对ARI的开发带来了更多难度,程序员不得不开发更先进的算法,让它能够判断出手掌与背景的深度差别,实现更准确的操作。 最后的问题则是电池寿命。显然,ARI在一定程度上会加重谷歌眼镜本身的运算负荷,如何保持良好的识别率、同时又能够节省电力,这也是ARI团队在技术上遭遇的挑战。 总得来说,智能眼镜产品距离成熟还有很长一段时间,不仅仅是因为它涉及到敏感的隐私问题,还在于其使用体验不完美、应用形式鸡肋,不如直接使用手机来得方便。不过,ARI的出现证明智能眼镜拥有极大的潜力,相信在不断地完善、优化之后,对智能眼镜的操作体验会产生积极的影响。

|  /4

/4

/4

/4